Entlarvend ist gleich zu Beginn des Threads zu Equalizern folgende Aussage des Blog-Autors: In my own experience, using home sound system, be it a Walmart bookshelf audio or British hi-end system alike, is grossly inadequate for this kind of experiments. Wer diesen Schlüsselsatz überliest ohne ihn zu analysieren, ist dem Autor bereits auf dem Leim gekrochen. Denn wenn eine Vorgehensweise, vorgeschlagen für PA-Systeme mit high end Audio, nicht funktioniert, stimmt etwas mit der Vorgehensweise oder dem Sachverstand des Autors nicht. Beide Threads des Autor beschäftigen sich damit, vor Ort, also an Milongas, das Bestmögliche aus den Aufnahmen der EdO herauszuholen.

Die richtige chronologische Reihenfolge der Threads dieser Replik vom März 2016:

01 – Vorbemerkungen | 02 – Das Grosseganze | 03 – Sackgasse Equalizer | 04 – Sackgasse Kompressor | 05 – Pragmatische Lösungen | 06 – Meine Legitimation | 07 – Kritische Würdigung | 08 – Schlussfolgerungen | 09 – Nachtrag: Pugliese | 10 – Nachtrag: Links | 11 – Nachtrag: Kritik

Ignorierte Fakten

Im Rahmen der gegebenen Aufgabe stossen sämtliche Audiogeräte logischerweise auf dieselben Herausforderungen und Probleme. Denn an der Aufgabe ändert sich nichts, nur weil verschiedenste Arten von Audiogeräten zum Einsatz kommen. Das eine ist die Aufgabe – sie ist gegeben. Das andere sind die Mittel – die kann man variieren, in Form verschiedenster Audiogeräte und unterschiedlichem Knowhow-Niveau des Anwenders, und damit die Aufgabe besser oder schlechter lösen. Weil Elektrik wie Mechanik all dieser Geräte bei der vom Autor definierten Aufgabe in jeder Wiedergabekette vor denselben Herausforderungen stehen, kann nicht sein, dass zwei Kategorien von Wiedergabeketten für solche Experimente auf derbe Weise unangemessen – Originalton Autor – sind: Schnäppchen-Kram und britisches high end. Einzig die Resultate fallen unterschiedlich aus.

High-end-Geräte, welche diese Bezeichnung tatsächlich verdienen, und Studiotechnik sind mit den Schwächen der Restaurationen der Aufnahmen der EdO genauso konfrontiert wie jedes andere Audiogerät. Sie zeigen diese, wenn sie tatsächlich besser sind, lediglich deutlicher, aber auch differenzierter. Walmart-Kram und billigst-PA aus dem Baumarkt oder vom Discounter kranken an den selben Symptomen, unterscheiden sich also nur wenig. Ausserdem gibt es in jeder Gerätekategorie, ein Stück weit unabhängig vom Preis, bessere und schlechtere Geräte, also zB gute und schlechte PA und damit PA, die ihrer Aufgabe gewachsen oder nicht gewachsen ist.

Ausserdem lassen sich diese Kategorien oft nicht eindeutig voneinander trennen. Die Sparte Hi-Fi, von der High End lediglich ein Teil ist, lässt sich kaum vernünftig abgrenzen, falls man Klangqualität zum Massstab macht und nicht den Preis oder eine grosskotzige Erscheinung. Und Studiotechnik lässt sich seit den 40er-Jahren gar nicht mehr klar davon abgrenzen. Seither gab es immer Geräte die in beiden Sparten erfolgreich waren. Drei Beispiele dazu: Ab Anfang der 40er- bis Ende der 60er-Jahre fand das Lautsprecher-Chassis 604 von Altec in beiden Sparten Verwendung. Dasselbe gilt seit Ende der 40er-Jahre für Dual-Concentric-Chassis von Tannoy. Seit Mitte der 80-Jahre stehen nicht nur in England in Studios, die sich Klassikkonserven verschrieben haben, beinahe ausschliesslich bestimmte Lautsprecher von Bowers & Wilkins im Einsatz. Solche Beispiele für spartenübergreifenden Einsatz liessen sich dutzendweise auflisten.

Diesen elementaren Widerspruch einer realitätsfremden Abgrenzung, in den sich der Autor gleich zu Beginn verstrickt, löst er nie auf. Er stellt seine Behauptung in den Raum und verzichtet darauf, sie zu begründen. Was mich nicht erstaunt, weil sich diese Behauptung unmöglich argumentativ unterfüttern lässt. Das ist nicht polemisch gemeint: Womöglich hat der Autor noch nie mit PA-Technik gearbeitet, die diesen Namen verdient. Ich will ihm das nicht unterstellen. Aber von der Hand zu weisen ist das nicht. Dieses Statement ist ein erster deutlicher Hinweis darauf, dass der Autor Unzulänglichkeiten ihm bekannter PA-Technik fälschlicherweise den Aufnahmen von TA der EdO zuschreibt. Minderwertige PA-Technik ist die einzig mögliche Erklärung für seine eigenartige Abgrenzung. Aber ganz erklärt das des Autors Ausrutscher nicht. Denn Schnäppchen-Kram von Walmart verhält sich klanglich ziemlich genau gleich destruktiv wie minderwertige PA-Technik. Trotzdem lehnt der Autor eines von beidem für seine Experimente ab. Es bleiben also Fragezeichen. Dieses eigenartige Statement des Autors stellt nicht nur seinen ganzen Ansatz in Frage, sondern auch sämtliche Schlussfolgerungen, die er uns anbietet. Bessere Audiotechnik – ganz egal, in welcher Marktsparte vermarktet – erlaubt es einem DJ wie gesagt lediglich, vorhandene Probleme auf subtilere Weise anzugehen, weil er genauer hört was Sache ist.

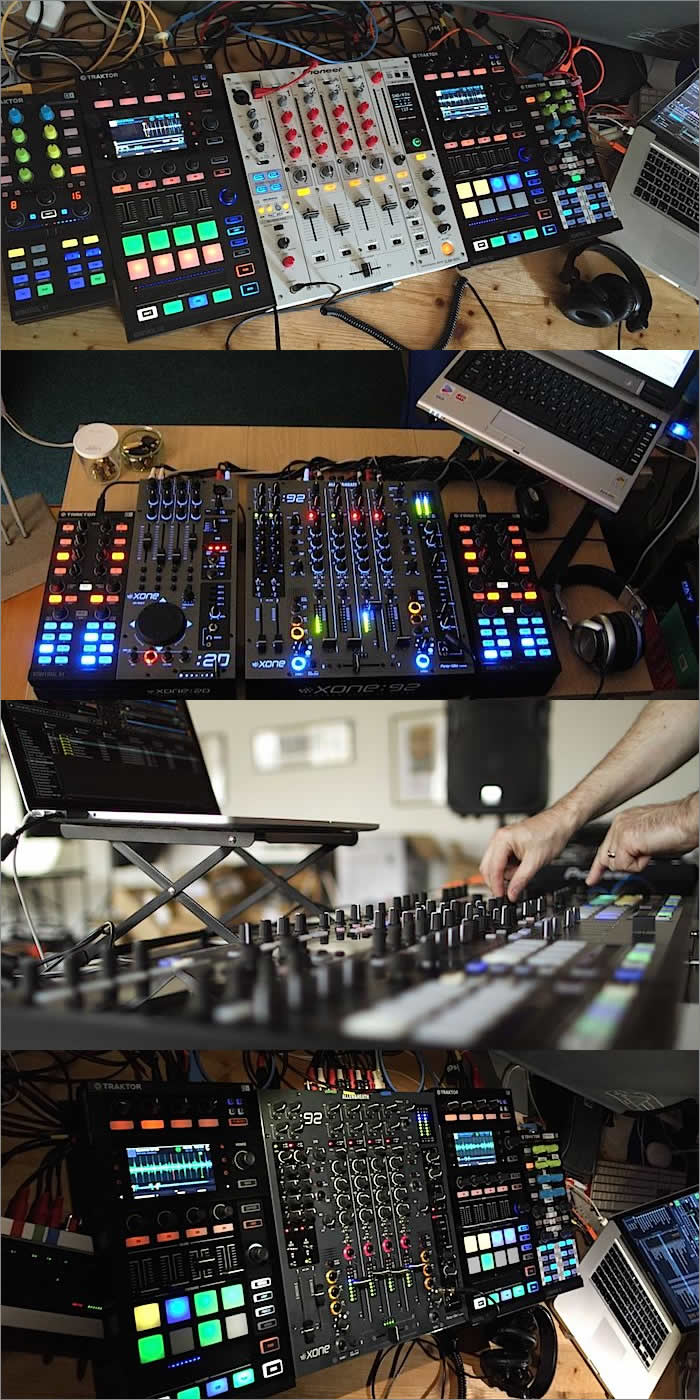

Trotzdem habe ich diese zentrale Aussage des Autors berücksichtigt, mit der er sich gleich zu Beginn ganz von allein demontiert. Denn Ziel dieser Replik ist es, den Dingen auf den Grund zu gehen. Da ich lieber mit Studio- anstatt PA-Technik auflege und daheim beinahe ausschliesslich Studiotechnik einsetze, habe ich Cassiel, der astreine PA-Technik sein Eigen nennt, gebeten, die Vorschläge des Autors ebenfalls auszuprobieren. Das war Teil der Vorbemerkungen. Cassiel und ich haben uns nicht abgesprochen. Ich habe ihn um seine Stellungnahme gebeten, nachdem meine Replik fertig geschrieben war. Cassiel hat meine Replik erst erhalten, nachdem seine Stellungnahme fertig geschrieben war.

Kommen wir zu den vier vom Autor angesprochenen Mythen für DJs im TA. Dort vertritt er nochmals Ansichten, die er lediglich als Behauptung in den Raum stellt. Jeder Audio-Profi, der etwas auf dem Kasten hat, kann über die Aussagen zwei und drei des Autors nur den Kopf schütteln: There is no cure for reverberation – wrong. If you equalize out the groove noise you will inevitably lose the musical content with it – wrong. Wenn die Mehrzahl der Macher im TA mehr Knowhow bezüglich Audiotechnik und Raumakustik hätte, könnte ich diese zwei Sätze des Autor unkommentiert stehen lassen und meine Replik mit diesem Satz abschliessen, weil alle den Kopf über den Autor schütteln und sich von ihm abwenden würden. Leider war und ist das Gegenteil der Fall.

Weil die Laufgeräusche einer Schellack sich zwangsläufig dasselbe Frequenzspektrum mit Musikinstrumenten und Sänger teilen – Musikkonserven verfügen nun mal nur über dieses eine Frequenzspektrum im hörbaren Bereich – kann man kaum Laufgeräusche wegfiltern, ohne Musikinformation zu entfernen. Weil man das sofort hört. Der Sound wird künstlich und hart, metallisch und kastenförmig, gequetscht und mulmig und ist trotzdem ganz schnell völlig zugemüllt, was sich nicht mehr beseitigen lässt. Hier kann man die Spreu nicht vom Weizen trennen, weil für beides nur ein Medium zur Verfügung steht: Luftschwingungen im für Menschen hörbaren Frequenzbereich. Hier gibt es kein Äquivalent schwerer Weizen versus leichte Spreu, der eine Trennung mittels Wind möglich macht, wenn man beides in die Luft wirft. Vor allem jene subtilen und daher leisen Anteile des Musiksignals lassen sich bei heftigem Filtern nicht bewahren, welche für einen Grossteil der Unmittelbarkeit und Live-Haftigkeit einer Aufnahme verantwortlich sind. Dasselbe gilt aus denselben Gründen für nachträglich hinzugefügten Hall, wie er ab 1960 bei Reeditionen auf LP und später auch auf CD sehr häufig zu finden ist. Dieser Mickey-Mouse-Hall kaschiert die natürliche Hallfahne des ursprünglichen Aufnahmeraums völlig und verschlimmbessert Restaurationen dramatisch und vor allem irreversibel. Dieser Kunsthall hilft höchstens, vor einem ungeschulten Ohr zu verbergen, wie schlecht so eine Restauration handwerklich gemacht ist. An all dem ändert auch das Marketing-Geplapper der Hersteller von software restauration suits nichts. So simpel, wie manche Entwickler von Algorithmen die Zusammenhänge darstellen, weil sie verkaufen wollen, ist das alles nicht. Die meisten dieser Werkzeuge sind Kinderkram für gear heads.

Künstlicher Hall besteht natürlich nicht aus angehobenen Frequenzen um 1kHz herum. Der lässt sich daher nicht, wie der Autor das vorschlägt, entfernen, indem Frequenzen um 1kHz herum abgesenkt werden. Wenn dem so wäre, hätte kein Tonstudiobetreiber mit einem Funken Verstand in den letzten 60 Jahren ein Gerät für künstlichen Hall angeschafft. TA der EdO und künstlicher Hall sind niemals eine gut klingende Kombination. Diese Aufnahmen brauchen so was nicht, weil der authentische Hall des Aufnahmeraums auf diesen Aufnahmen auf Grund der Mikrophonaufstellung bestens konserviert ist. Popaffine DJs und viele Tontechniker sind sich dieser Zusammenhänge aus der Zeit vor 1950 aber schon seit Jahrzehnten nicht mehr bewusst.

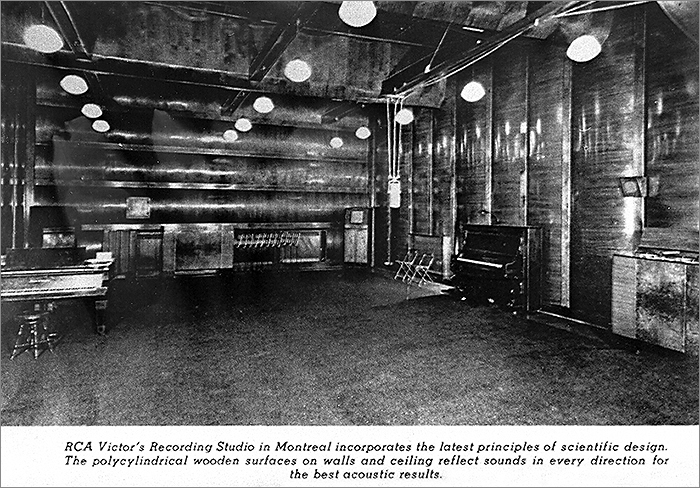

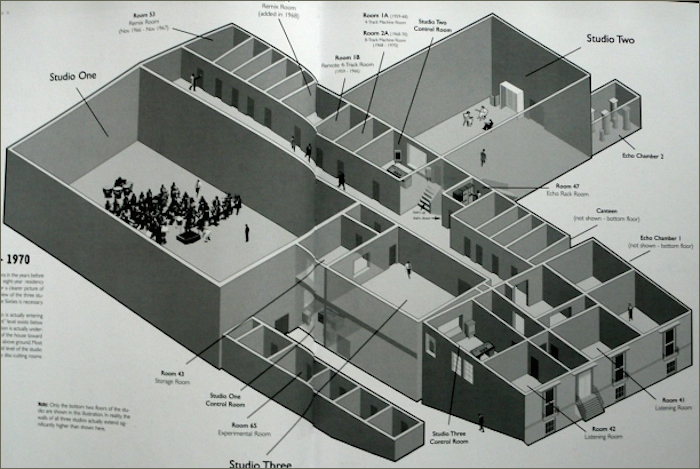

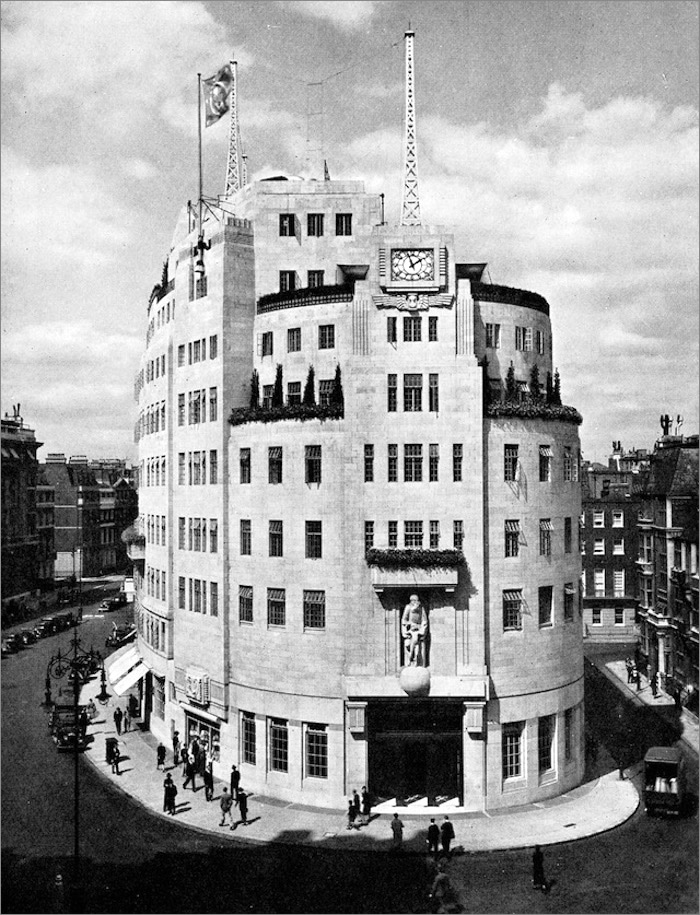

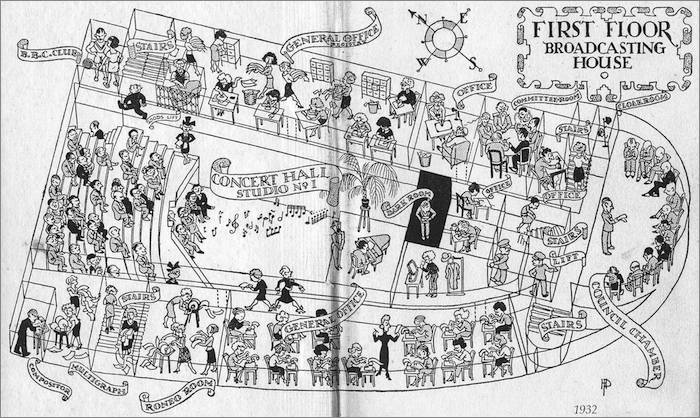

Mit dem Wechsel vom akustischen zum elektrischen Aufnahmeverfahren im Jahr 1926 zeigte sich schnell, dass sich die bisherigen Aufnahmeräume – ziemlich klein und bedämpft, zwecks minimaler Reflexion – für die neue Technologie kaum eignen. Es hat einige Jahre gedauert, bis die Plattenlabels das wieder im Griff hatten. Die ersten Studiokomplexneubauten, in denen diese Erkenntnis kompromisslos umgesetzt wurde, waren EMIs Abbey Road Studios in London und das Haus des Rundfunks in Berlin, beide 1931 eröffnet. Die Plattenlabels und Radiostationen rund um den Erdball haben ab 1928 alles unternommen, um diese Probleme in ihren Studios schnell in den Griff zu bekommen. Das ist den letzten major-label-Studios bis Mitte der 30er-Jahre gelungen. Es gab damals kaum unabhängige Studios wie seit den 50er-Jahren üblich, wie zB Sun Records oder Blue Note, Atlantic oder Motown, Prestige oder Riverside in den USA. Über 90% der Musikkonservenproduktion entstand vor 1945 weltweit in labeleigenen Studios der majors oder akustisch besonders guten Konzertsälen, wo die majors ebenfalls nur das Beste vom Besten an Technik zum Einsatz brachten. Die ersten künstlerisch wichtigen, unabhängigen Tonstudios der elektrischen Ära in den USA waren das United Sound Studio in Detroit ab 1933 und die Universal Recording Corporation ab 1946 in Chicago. Unabhängige Studios waren aber von Anfang an nicht nur für independent labels tägig, sondern gerne auch für die majors.

Ein Beinahezeitzeuge erzählt, zu welchen Verwerfungen der Wechsel vom akustischen zum elektrischen Aufnahmeverfahren in der Plattenindustrie um 1930 herum geführt hat.

Ein Beinahezeitzeuge erzählt, zu welchen Verwerfungen der Wechsel vom akustischen zum elektrischen Aufnahmeverfahren in der Plattenindustrie um 1930 herum geführt hat.

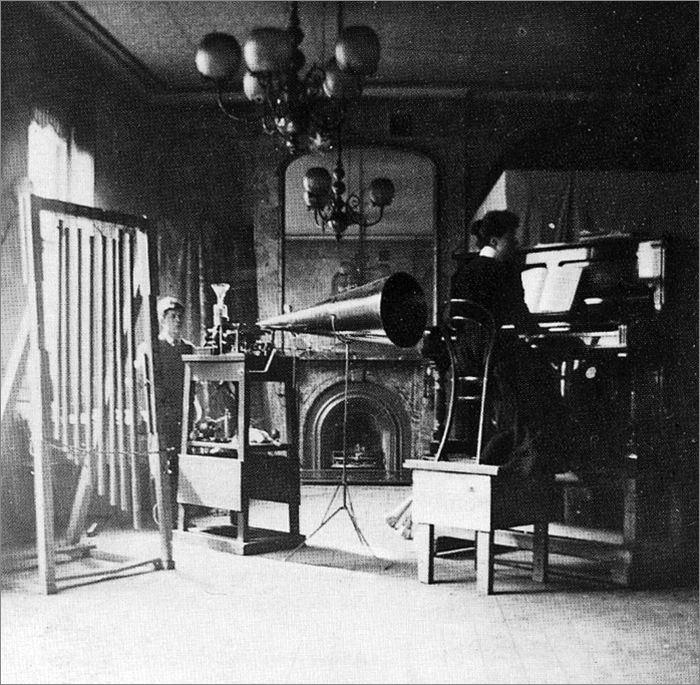

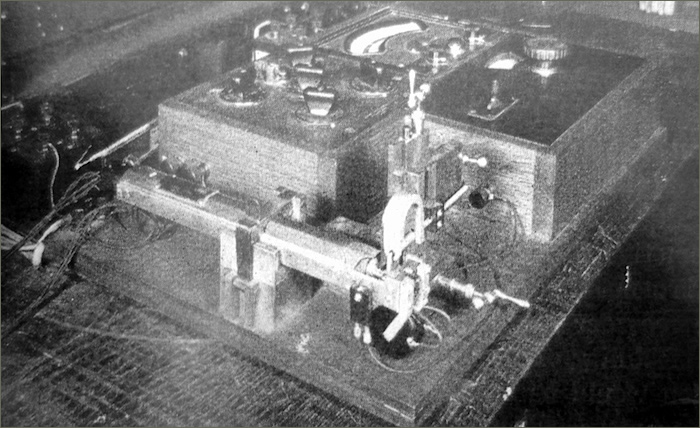

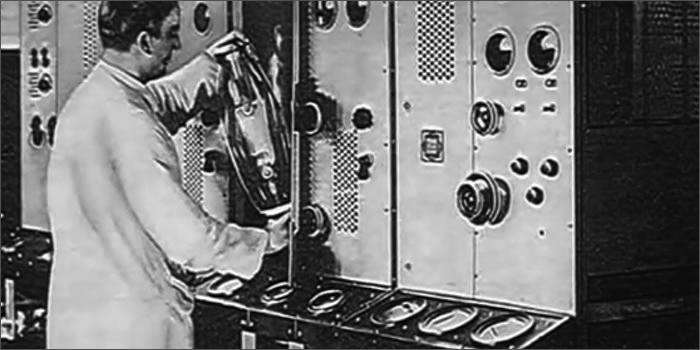

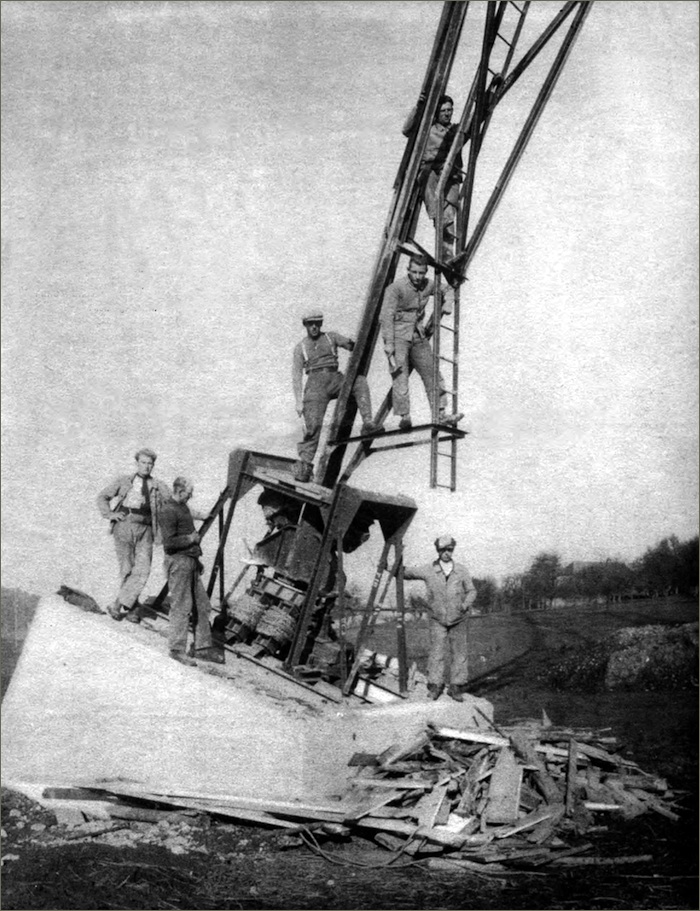

Aufnahmeapparatur für das mechanischen Verfahren, welches etwa bis 1926 in Gebrauch war. 1898 in London aufgenommen. Dieses Setup hat nichts mit der realen Aufnahmesituation zu tun. Dafür zeigt es das Aufnahmegerät. Meist ist nur der, sind nur die Aufnahmetrichter auf Fotos zu sehen, die aus einem Zelt, einer Wand herausschauen, so wie auf dem Foto unten. Für die Tonaufnahme stand das Gerät inklusive Trichter hinter dem Piano im eigens dafür im Raum aufgebauten Zelt, aus dem lediglich das Ende des Trichter herausschaute, direkt auf die offene Rückwand des Pianos gerichtet. Es galt damals als unschicklich, die Musiker dem unästhetischen Anblick von Aufnahmetechnik auszusetzen.

Aufnahmeapparatur für das mechanischen Verfahren, welches etwa bis 1926 in Gebrauch war. 1898 in London aufgenommen. Dieses Setup hat nichts mit der realen Aufnahmesituation zu tun. Dafür zeigt es das Aufnahmegerät. Meist ist nur der, sind nur die Aufnahmetrichter auf Fotos zu sehen, die aus einem Zelt, einer Wand herausschauen, so wie auf dem Foto unten. Für die Tonaufnahme stand das Gerät inklusive Trichter hinter dem Piano im eigens dafür im Raum aufgebauten Zelt, aus dem lediglich das Ende des Trichter herausschaute, direkt auf die offene Rückwand des Pianos gerichtet. Es galt damals als unschicklich, die Musiker dem unästhetischen Anblick von Aufnahmetechnik auszusetzen.

[caption id="attachment_3041" align="aligncenter" width="700"]

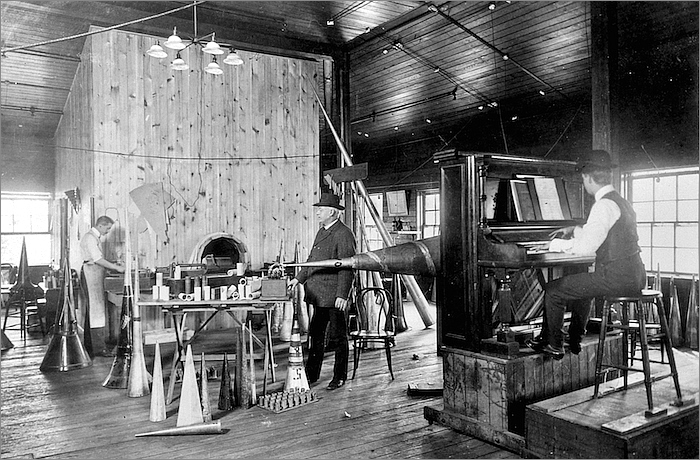

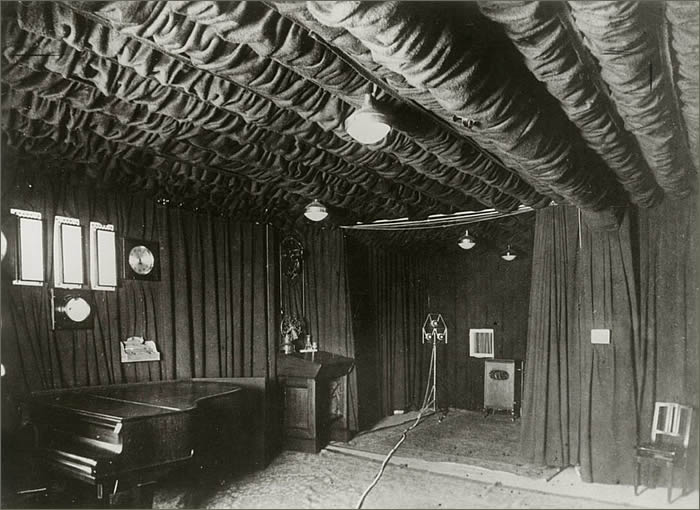

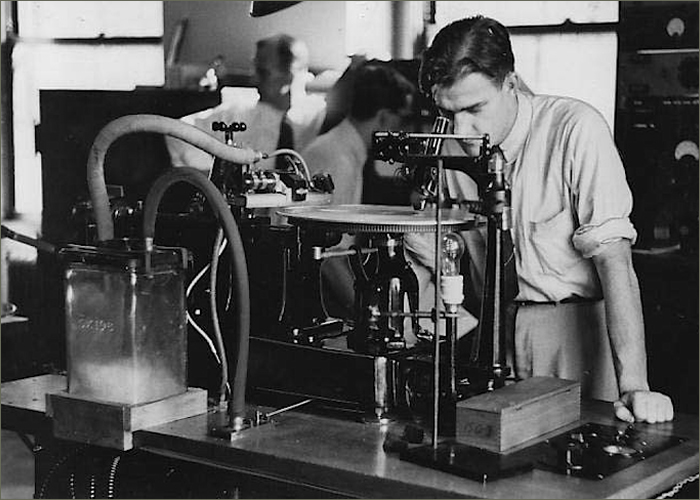

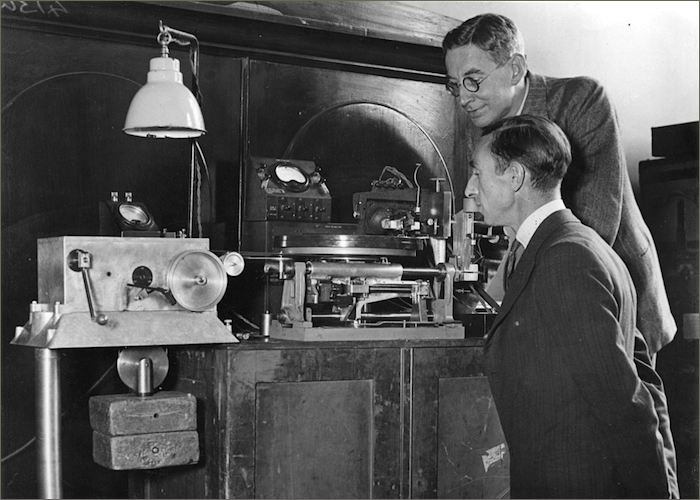

Ein weiteres Beispiel für ein Aufnahmestudio der akustischen Ära. Gut zu sehen ist die grosse Auswahl an unterschiedlichen Aufnahmetrichtern, die damals zum Einsatz kamen.

Ein weiteres Beispiel für ein Aufnahmestudio der akustischen Ära. Gut zu sehen ist die grosse Auswahl an unterschiedlichen Aufnahmetrichtern, die damals zum Einsatz kamen.

Diese sechs Fotos von gran orquestas belegen hoffentlich deutlich genug, dass solche Fotos vor allem von den Studios der beiden dominierenden Plattenlabels nie Rückschlüsse darauf ziehen lassen, wie damals im Studio aufgenommen wurde – mit welcher Plazierung der Musiker im Raum, mit welcher Plazierung des Mikros, der Mikros zu Musikern und Raum. Das wurde damals in allen Labelstudios weltweit als zu schützendes Betriebsgeheimnis verstanden. Fotos aus Radiostudios verraten darüber sehr viel mehr.

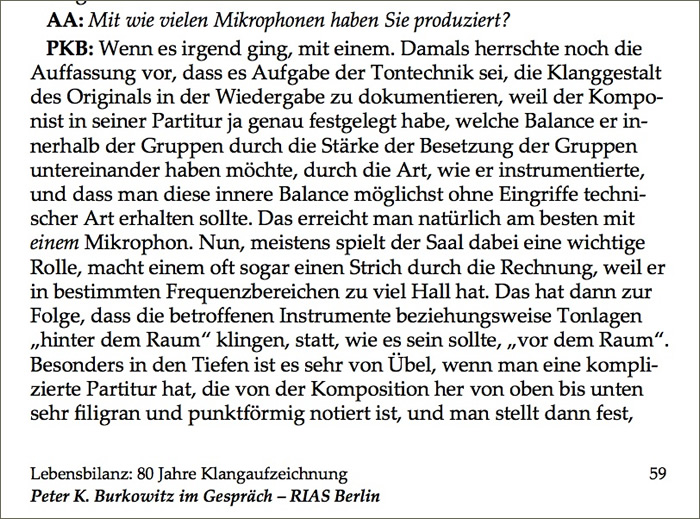

Die Aufnahmen des TA der EdO benötigen keinen künstlichen Hall, obwohl in BA ab 1936/37 – für RCA-Victor im Fall von d’Arienzo inzwischen verifiziert – die monauralen Aufnahmen mit mehreren Mikrophonen gemacht wurden. Meist waren es zwei bis drei. Hören kann man das zB daran, dass der Konzertflügel, welcher im Studio damals nie unmittelbar vor dem Hauptmikrophon stand, weil er die restlichen Instrumente sonst akustisch erschlagen hätte, ab einem bestimmten Aufnahmedatum nicht mehr wie bei früheren Aufnahmen distanziert und verhalten klingt, wie wenn er im Raum im Hintergrund stehen würde. Er ist so präsent wie die anderen Instrumente. Das liess sich nur durch mindestens ein zweites Mikro lösen – oder durch einen Aufnahmeraum, der über eine optimale Akustik im Bassbereich verfügte. Dann lässt sich so ein Resultat auch mit einem Mikro erzielen.

In BA wurde meines Wissens nach 1933 weder bei Odeon noch bei RCA-Victor die Studioakustik verbessert. Aber womöglich fehlen mir dazu verlässliche Angaben. Vielleicht wartet da noch die eine oder andere Überraschung auf uns, die nahelegt, dass immer nur mit einem Mikro aufgenommen wurde. Möglich ist alles, wenngleich nicht wahrscheinlich.

Denn bei den Aufnahmen d’Arienzos der zweiten Hälfte von 1936 kann man sehr gut hören, wie mit der Mikrophonaufstellung experimentiert wurde. Es ist aber auch zu hören, dass ab 1937 in diesem Studio wieder technische Kontinuität einkehrte. Die Zeit der Experimente war vorüber. Trotzdem wurde der Mix damals in erster Linie durch die Position der Instrumente untereinander und im Raum definiert, ohne Trennwände oder andere Hilfsmittel. Es versteht sich von selbst, dass so ein puristisches Mikrophon-Setup bei einem durch das Mischpult gegebenen Maximum von vier Kanälen ohne Zugabe künstlicher Verhallung wunderbar klingt, falls der Tonmeister sein Metier beherrscht. Close-miking gab es damals höchsten für den Sänger, aber nie für Instrumente. Das wurde damals aber nicht in dem Mass auf die Spitze getriebenen, wie Sänger das ab 1950 taten.

Der nie endende Streit darüber, wie viele Mikros für monaurale Aufnahmen auf Wachsmaster für Schellackplatten jeweils verwendet wurden, ist leider ein Schlachtfeld, auf dem Menschen sich gegenseitig verbal an die Gurgel gehen – mit der festen Überzeugung sie wüssten es ganz genau. Ich tendiere zur Ansicht, dass sich diese Frage am besten von einem Tonmeister beantworten lässt, der genug Erfahrung mit bringt: wieder mal hörend anstatt sehend.

Denn viele der heute herum gereichten Fotos wurden während Experimentalphasen aufgenommen, wie zB während dem Entwickeln und Experimentieren mit stereofonen Aufnahmen oder neuen Formaten während der 30er-Jahre. Mit dem regulären monauralen Aufnahmebetrieb für Schellacks aus dieser Zeit hat das wenig zu tun. Ausserdem wurden bei vielen Labels Fotografen erst ins Studio gelassen, nachdem man Mikrophone verschoben hatte, damit kein labelspezifisches Knowhow betreffend Mikrophonplazierung nach aussen dringen konnte. Ausserdem muss nicht jedes im Raum aufgestellte Mikrophon ständig in Betrieb gewesen sein. Vielleicht wollte man Besucher und Fotografen damit in die Irre führen. Vielleicht hat man zu Beginn der Aufnahmen mit Varianten experimentiert. Womöglich hat man präventiv das eine oder andere Stützmikro aufgestellt und eingepegelt, damit man, falls es notwendig werden sollte, möglichst wenig Zeit verliert. Vielleicht waren später am Tag ganz andere Aufnahmen angesetzt, mit einer anderen Orchestergrösse, und dafür war die Mikroaufstellung bereits definiert und aufgestellt, getestet und eingepegelt. Vielleicht hat man getweakte Mikros mit unverbastelten Mikros verglichen oder unterschiedliche Mikros miteinander. Das technische Manual der Studios von RCA-Victor aus dem Jahr 1939/40 in BA – dazu später mehr – dokumentiert ausschliesslich die von den Mikroherstellern propagierte Aufstellung eines einzigen Mikros für das ganze Orchester. Das Mischpult dieses Labels hatte aber bereits vier Kanäle. Die Möglichkeiten sind also vielfältig, und heute kann man bisher nur in Ausnahmefällen identifizieren, was damals tatsächlich Sache war betreffend Mikrophonanzahl und -plazierung.

Aufschlussreich ist allerdings, was Burkowitz über die Aufnahmepraxis in der ersten Hälfte der 50er-Jahre erzählt – also einem viel späteren Zeitpunkt, den letzten Jahren der monauralen Ära. Es war damals unter Könnern des Metiers für akustische Instrumente im Interesse der Klangqualität immer noch üblich, mit einem einzigen Mikro zu arbeiten, falls die Raumakustik im Bassbereich dafür gut genug war. Denn das ist der heikle Punkt in diesem Zusammenhang. Dieses Vorgehen ist tatsächlich verbürgt – zweifelsfrei. Falls die Raumakustik nicht gut genug war, war man gezwungen mehr als ein Mikro einzusetzen, mindestens zwei.

Ab Schellack oder mittels guter Restaurationen wie der Golden Ear Edition von TangoTunes wiedergegeben hört man die Reflexion des Aufnahmeraums klar und deutlich, was Aufnahmen eine atemberaubende Live-Haftigkeit zurückgibt. Vorausgesetzt, die Wiedergabetechnik ist gut genug und man weiss, mit welchem nicht offensichtlichen Setup man diese Live-Haftigkeit wo im Raum optimal hört. Gute Restaurationen haben viel mit Archäologie gemeinsam: Es geht darum, so viel wie irgend möglich von der ursprünglichen Substanz zu konservieren, bevor man damit beginnt, Fehlendes mit heutigen Mitteln zu ergänzen oder grössere Lücken zu kaschieren oder offenzulegen. Dabei darf das, was man ergänzt, auf keinen Fall Bestehendes beeinträchtigen, indem zB unzeitgemässe Technologien oder ein unangemessenes Klangideal zum Einsatz kommen. Es ist alles eine Frage der richtigen Reihenfolge und des angemessenen Masses – und natürlich der Ehrlichkeit. Im TA der EdO werden beim Restaurieren zu oft Dinge praktiziert, die dem Bemalen von Nofretetes Büste mit einem Pinsel zum Tapezieren entspricht – mit Acrylfarben.

Bei schlecht gemachten Restaurationen von TA der EdO wurde und wird nach dem Transfer mangels Kompetenz, mit der Absicht, sämtlichen Laufgeräuschen der Schellack gnadenlos den Garaus zu machen, so heftig gefiltert und algorithmiert, dass neben subtilen und weniger subtilen Anteilen des Musiksignals die natürliche Hallfahne dieser Aufnahmen gänzlich ihr Leben lassen muss. Weil das Resultat dieser Rosskur grässlich klingt, versuchen die Berserker hinter diesem Konzept anschliessend ihre radikalkastrierten Pseudorestaurationen mit künstlichem Hall und anderem Audiotechnik-Firlefanz aus der Pop-Welt irgendwie zu reanimieren – meist nach dem Motto, dass angesichts der desolaten Situation noch viel mehr Doping besser sein muss als viel mehr Doping. Und ja, das Resultat solcher Eskapaden klingt nicht nur im Tonstudio nach Frankenstein in Personalunion mit Freddy Krueger. Mit dieser Kernspalt-Mentalität raubt man TA der EdO die klangliche Seele. Dieser flüchtige Aspekt der Musik lässt sich hinterher nie mehr herbeizaubern. Auch nicht mit einer ganzen Batterie von Equalizern, Kompressoren, Gates, Excitern, Limitern und weiss der Teufel was noch. Einmal klanglich platt gemacht lässt sich TA der EdO nicht mehr aufblasen. Abertausende von Löchern im Musikgeschehen lassen sich nie mehr stopfen, weil die kläglichen klanglichen Reste des Originals nichts mehr verbindet. Da ist nur noch Stückwerk.

In den letzten 20 Jahren sind viele hundert CDs dieser Kategorie mit TA der EdO auf den Markt gekommen. Das ist keine Randerscheinung. Wer nun noch einen Equalizer auf die vom Autor vorgeschlagenen Weise nachträglich über ganze Aufnahmen drüber bügelt, oder einen Algorithmus, verstärkt man nicht nur mit schlecht sondern auch mit gut gemachten Restaurationen jenen sattsam bekannten Unklang von Restaurationen, welche wir vor allem von vielen argentinischen Labels gewohnt sind: Der Klang der acht- bis sechzehn-Mann-Orchester ist obenrum dünn und schrill, untenrum aufgedickt und muffig, über alles komprimiert und kastriert. Stimmen haben kein Fundament und klingen metallisch. Die einzelnen Instrumente der Bandoneon- und Streichersektion trennen klanglich kaum, Bandoneon oder Geige solo fehlt die Körperlichkeit. Beim Kontrabass hört man die Saiten nicht, weil er zu einer verfetteten Kontrabasstuba mutiert ist, falls man ihn überhaupt hört. Und dem Konzertflügel fehlen nicht nur die Flügel sondern auch der Resonanzboden. Und überhaupt fehlen den Instrumenten, und noch viel mehr der Stimme, die Farben und der Dynamik die Unmittelbarkeit. Was übrig bleibt ist ein arger Abklatsch.

Manipulation und Wahnehmung

Zudem wurden viele Restaurationen beschleunigt, was die musikalischen Proportionen vollends auf den Kopf stellt und unnatürlich klingen lässt, weil damit am Grundtimbre der akustischen Instrumente herumgefummelt wurde. Das kann bereits bei der Aufnahme geschehen sein. Die Gründe dahinter sind nicht grundsätzlich von der Hand zu weisen. Hier eine angemessene Abwägung vorzunehmen ist eine Herausforderung. Trotzdem bleibt so eine verfälschende Vorgehensweise problematisch und darf in Frage gestellt werden. Meist und grösstenteils haben das aber unprofessionell erstellte Restaurationen verursacht, für die das Plattenlaufwerk nicht kalibriert wurde oder an dem absichtlich Veränderungen vorgenommen wurden.

Es ist nicht die Aufgabe von Tontechnikern oder Restauratoren, mittels Tonhöhenveränderung virtuell quasi die Bauweise von Instrumenten gemäss zeitgeistigen Vorstellungen zu verändern und damit Klangveränderungen zu simulieren. Denn das ist das Ergebnis solcher Manipulationen. Das funktioniert auch mit Algorithmen nicht, die versprechen, das Tempo zu verändern, ohne die Tonhöhe zu verändern – oder umgekehrt. Gut genug gemacht wäre die eigentlich anvisierte Tonhöhenveränderung nicht das Problem – falls die richtig definiert wurde. Aber weil damit immer auch das Grundtimbre jedes Instruments und jeder Stimme verändert wird – jedes Instrument hat unabhängig von der Tonhöhe jedes gespielten Tons ein gleichbleibendes Grundtimbre, welches darauf beruht, dass jedes einzelne Bauelement eines Instruments auf seine ureigene Weise mitschwingt und damit ein klein wenig oder ganz viel zum unverwechselbaren Grundklang eines Instruments beiträgt – führt so eine Veränderung immer auch ein Stück weit zu einem künstlich anmutenden Gesamtklang, was unser Ohr als einen Anflug von Hysterie wahrnimmt, unnatürlich. Hätte man die Instrumente vor der Aufnahme entsprechend gestimmt, wäre das Grundtimbre der Instrumente nicht verändert worden in Richtung künstlich.

Ein Restaurator tut aber gut daran, konservierte Tonhöhenfehler zu kompensieren, was ausschliesslich in der analogen Domäne gut klingend realisierbar ist. Wenn Arrangeure/Musiker/Orchesterleiter sich für bestimmte Instrumente, einen bestimmten Kammerton, ein bestimmte Spielweise entschieden haben, führen nachträgliche vorgenommene Veränderungen immer zu Verschlechterungen. Denn die Kreativen von damals wussten ganz genau, was sie warum taten.

Kein Kunstliebhaber kommt auf die Idee, über einen Originalabzug von Ansel Adams ein Graufilter zu legen, mit der Behauptung, so würde das Foto besser aussehen und überhaupt, das sei zeitgemässer, modern eben. Ansel Adams hat für Belichtung und Entwicklung seiner grossformatigen Schwarzweissnegative das von ihm entwickelte Zonensystem verwendet und wusste ganz genau, was er tat. Diese in der Fotografie selten anzutreffende systematische Präzision wird in der Musik seit jeher zwangsläufig in einem noch grösseren Mass praktiziert, weil unser Ohr um eine Zehnerpotenz höher auflöst als unser Auge.

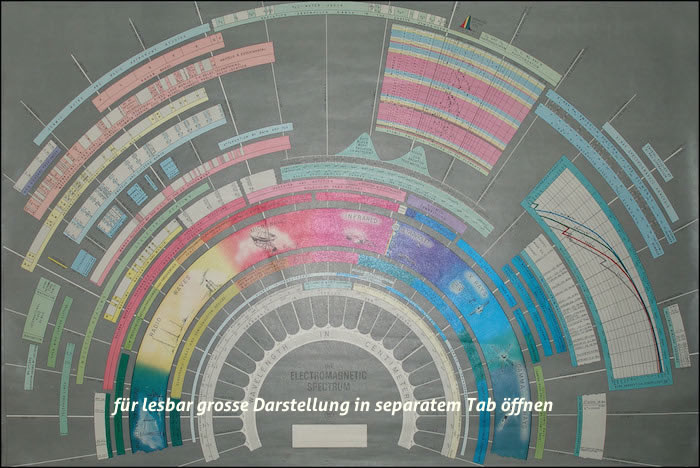

Unser Auge vermag den Frequenzumfang (das Farbspektrum) einer Oktave zu sehen und zu unterscheiden. Unser Ohr dagegen vermag zehn Oktaven zu sehen und zu unterscheiden. Sogar ein alter Mensch mit eingeschränktem Hörspektrum vermag mit dem Ohr immer noch ein Vielfaches der Bandbreite seines Auges wahrzunehmen, meist achteinhalb bis neun Oktaven. Auf Grund dieser phänomenalen Leistung unseres Gehörs gibt es in Sachen Tönen null Spielraum. Wir hören sofort, wenn bei Live-Darbietungen oder Musikwiedergabe ab Konserve etwas nicht stimmt.

Daher sind viele visuelle Darstellungen von technischen Analysen von Tönen wertlos. Unser Auge ist nicht fähig, solche Darstellungen auf einem Bildschirm differenziert genug wahrzunehmen und ein Bildschirm noch weniger, weil unsere Unterscheidungsfähigkeit bezüglich Farbtönen um eine Zehnerpotenz zu niedrig ist. Nicht mal ein kalibrierter Bildschirm vermag das. Konkret: Wenn unser Auge es schafft, 256 Graustufen wahrzunehmen, klingt das beeindruckend. Dann schafft es unser Ohr aber, 2560 Stufen wahrzunehmen. Wenn wir Klänge analysieren und für das Auge sichtbar darstellen wollten, würden wir daran scheitern, dass wir nur jede zehnte(!) hörbare Stufe mit dem Auge erkennen würden. Dem macht aber, wie gesagt, der Bildschirm einen Strich durch die Rechnung, weil dessen Bandbreite an Stufen noch kleiner ist als die unserer Augen. Würden wir darauf aufbauend Musik manipulieren – zB mittels Spektralanalysen – , wäre unsere Korrektur meist zu grob. Wir würden daher immer mehr verändern als gewollt, könnten das auf dem Bildschirm jedoch nicht erkennen. Aber hören würden wir das sofort.

Daher darf man als DJ mit Amateur-Anspruch – zu Profis werden wir sowieso nie werden – beim Arbeiten mit Klängen nie vergessen, dass überall dort, wo das Auge dem Ohr zur Hand geht, das Auge mangels Leistungskapazität das Ohr betrügt. Das Auge stösst bei solchen Anwendungen schnell an die Grenzen seiner Fähigkeiten. Immer noch zu viel Theorie, um die Tragweite dieser Tatsache zu begreifen? Das ist nicht einfach so daher gesagt. Ich kenne Dutzende von DJs, die sich weigern, die Konsequenzen zu ziehen, die sich aus diesen banalen Fakten ergeben.

Stellen wir uns vor, wir fahren Motorrad und beschleunigen von 0km/h auf 100km/h. Und zwar genau um einen km/h pro Sekunde, was eine Minute und 20 Sekunden dauert. Wenn das Ohr diesen Prozess steuert, gibt das eine Beschleunigung mit Sprüngen von einem km/h pro Sekunde. Wenn das Auge diesen Prozess steuert, gibt das auf Grund mangelnder Auflösung jeweils neun Sekunden ohne Beschleunigung und dann in einer einzigen Sekunde einen Beschleunigungssprung von zehn km/h und damit einen Ruck, der uns beinahe den Lenker aus den Händen reisst, falls wir uns nicht rechtzeitig vor jedem Geschwindigkeitssprung am Lenker festkrallen. Eine kontinuierliche Beschleunigung von 10km pro Sekunde ist banal. Es gibt seit Jahrzehnten Motorräder die das mit links toppen. Das Problem ist der rasante Wechsel von gleichbleibender Geschwindigkeit zum Temposprung und zurück zu gleichbleibender Geschwindigkeit innert einer Sekunde.

Wie gut handwerklich einwandfrei gemachte Restaurationen von EdO-Aufnahmen klingen können, hat TangoTunes Anfang 2015 mit jenem Teil der d’Arienzo-Restaurationen der Jahre 1935–39 bewiesen, für die Schellacks in gutem Zustand zur Verfügung standen. Bei den restlichen Restaurationen wird hoffentlich nachgebessert werden, falls TangoTunes bessere Schellacks findet.

Wer die Aufnahmen von damals in bestmöglicher Qualität hören möchte, kommt nicht darum herum, einige Glaubensbekenntnisse beiseite zu legen, die uns eine verantwortungslos neomanische Audioindustrie in den letzten Jahrzehnten eingetrichtert hat. Wer nicht damit zufrieden ist, zu einem Abklatsch der Aufnahmen von damals zu tanzen, muss vor allem bereit sein zu entdecken, wie schnell unser Gehör lernt, störende Laufgeräusche einer Schellack sehr viel gekonnter wegzufiltern als jeder Equalizer, jeder Algorithmus auf dem Markt. Noch ist unser biologischer Supercomputer Hirn bei dieser Aufgabe modernster Technik, ganz egal ob analog oder digital, deutlich überlegen und erledigt diesen Job auch noch kostenlos mit links.

Wer hören will, was in den Aufnahmen der EdO an Musizierlust und -qualität steckt, hat sich daher mit den Laufgeräuschen der Schellack anzufreunden – anstatt die Laufgeräusche pikiert abzulehnen und sich darauf zu konzentrieren, anstatt auf die Musik. Das ist eine Frage des mentalen Fokus. Probleme damit haben eigentlich nur MP3-verbildete Ohren von Menschen, die nie gute Konzerte besuchen. Ohne Mecker-Attitüde wird das Hirn schon nach ein, zwei Stunden gelernt haben, vermeintlich Störendes ganz nebenbei zielsicher auszublenden. Was man nicht mehr verlernt. Voraussetzung dafür in einem Tanzschuppen ist PA-Technik, die TA der EdO gewachsen ist. Der grösste Teil des heutigen PA-Sortiments hat nämlich die Unart, die Laufgeräusche einer Schellack hervorzuheben und die Musik, die eigentlich da wäre, zu kaschieren, weil die Mitten nicht angemessen wiedergegeben werden. Das verursachen aber wie gesagt nicht die Restaurationen, sondern die PA-Technik. Ursache und Wirkung verwechseln gilt nicht.

Zwei der vier der vom Autor gegebenen Antworten zu den erwähnten Mythen führen in die Irre. Ausserdem liefert er keinerlei Begründungen für seine Behauptungen. Er stellt sie einfach in den Raum und hofft, dass niemand mit profundem Wissen das hinterfragt. Einem Restaurations-Profi zeigen seine Antworten zu seinen sogenannten Mythen, dass das Verständnis des Autors für Aufnahmetechnik von damals und Restaurationspraxis von heute nicht reicht, um zu realistischen Einschätzungen zu gelangen.

Zu grundsätzlichen Fakten vermittelt der Autor eine ganze Reihe nützlicher Informationen – für technisch gänzlich unbeleckte DJs. Aber mittendrin macht er plötzlich eine Aussage, die man so unmöglich stehen lassen kann: Subjectively, human ear perceives the 10 dB change in the signal level as twice as loud, and 1 dB change as barely perceivable. Das ist ein deutlicher Hinweis darauf, dass des Autors Gehör Defizite aufweisen muss. Ich erlebe als DJ an Milongas immer wieder, dass eine Lautstärkeänderung von 1dB bereits zu viel ist und benütze dann Schritte von einem halben dB.

Verdrehte Geschichte

Die endgültige Verwirrung, die der Autor beim oberflächlichen Leser provoziert, beginnt einen Abschnitt über dem ersten Frequenzschrieb, wo er erklärt, wie damals aufgenommen wurde. Bereits hier vergleicht er Äpfel mit Birnen und übersieht Fehler und Ungenauigkeiten seiner Quellen.

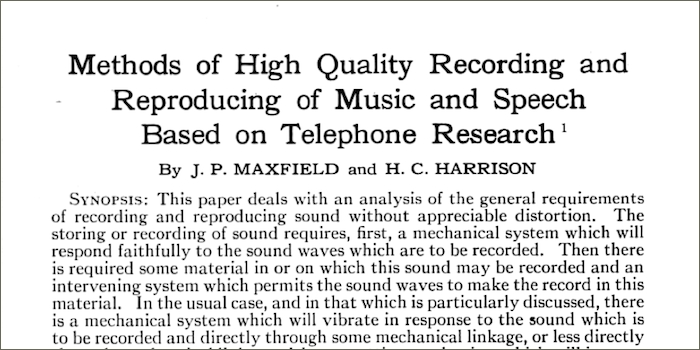

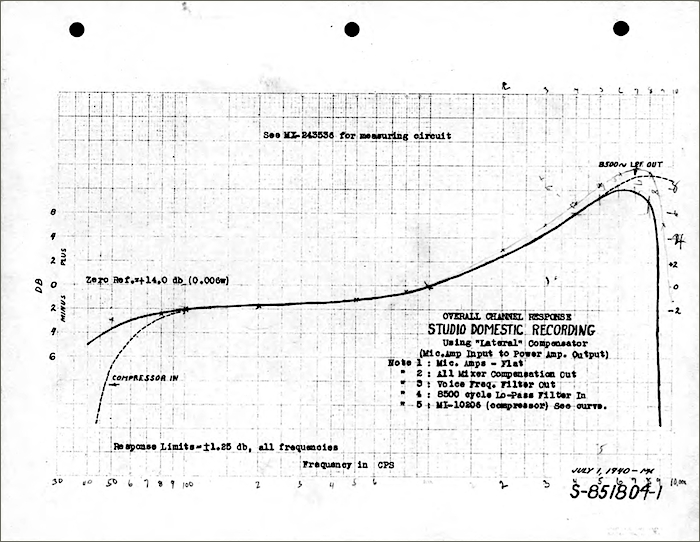

Eins der fünf wichtigsten Dokumente dieser Replik:

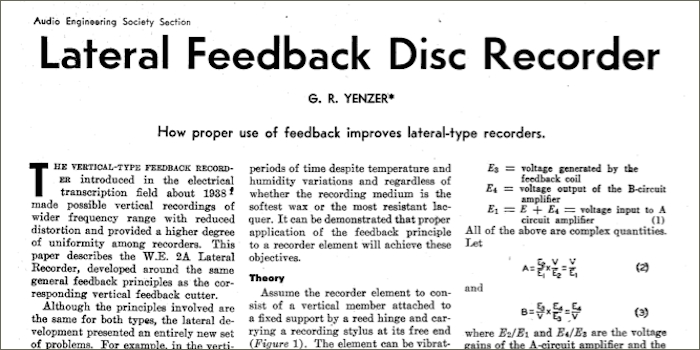

Der Autor schreibt den abgebildeten Frequenzschrieb einem Schneideverstärker zu, obwohl das der Frequenzschrieb eines Schneidekopfes (damals auf Englisch recorder, oder cutting head) ist. Here is a frequency profile of a typical recording amplifier of the 30s. Das sind aber zwei Paar Schuhe. Der Frequenzschrieb trägt die Legende: Tipical frequency characteristic of a commercial recorder. In der dazu zitierten akademischen Website, die wiederum aus journalistischen Artikeln aus den frühen 30er-Jahren zitiert, wird dieser Frequenzschrieb fälschlich der Aufnahmekette zugeschrieben. This amplifier is designed to cut off the bass, in accord with a recording policy, so as to give an over all response characteristic as shown below which has the authority of the Bell Telephone Laboratories. Weil bei dieser Aufnahmekette beim Schneidekopf zudem mechanische Dämpfung zum Einsatz kommt, ist das alles nicht so einfach. Und das ist lediglich eine der unzulässigen Vereinfachungen, die beim Autor zu falschen Schlussfolgerungen führen müssen.

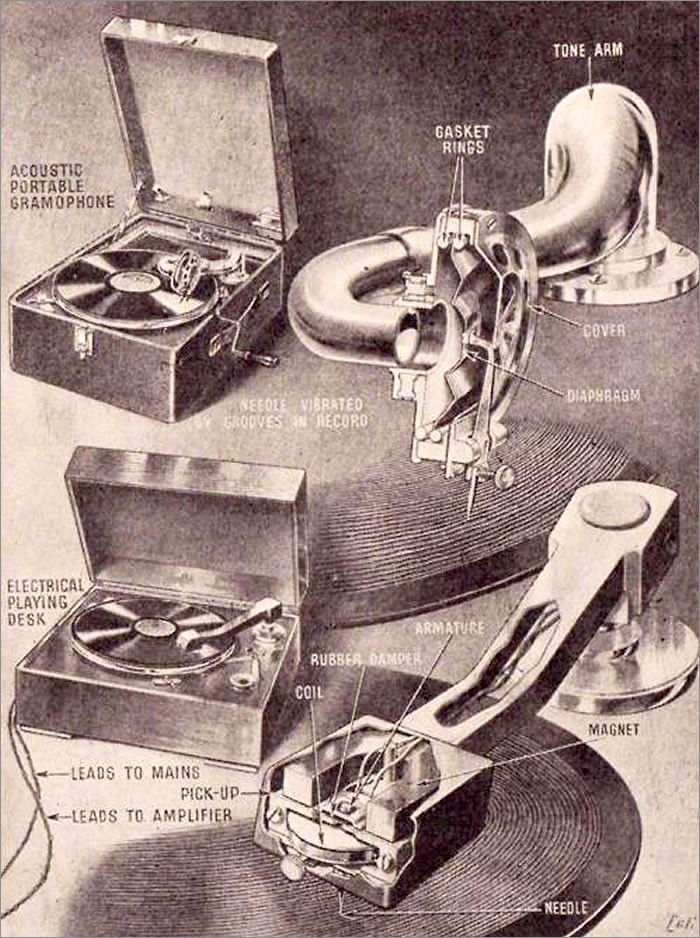

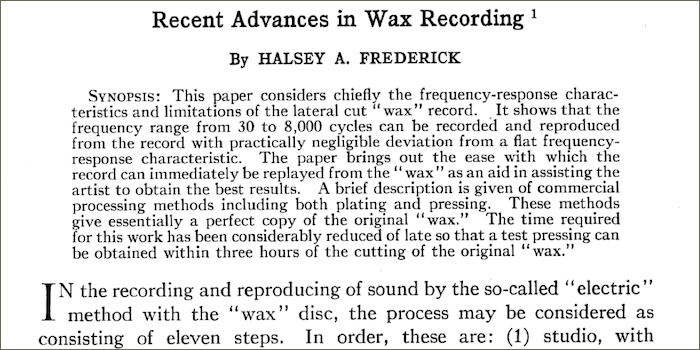

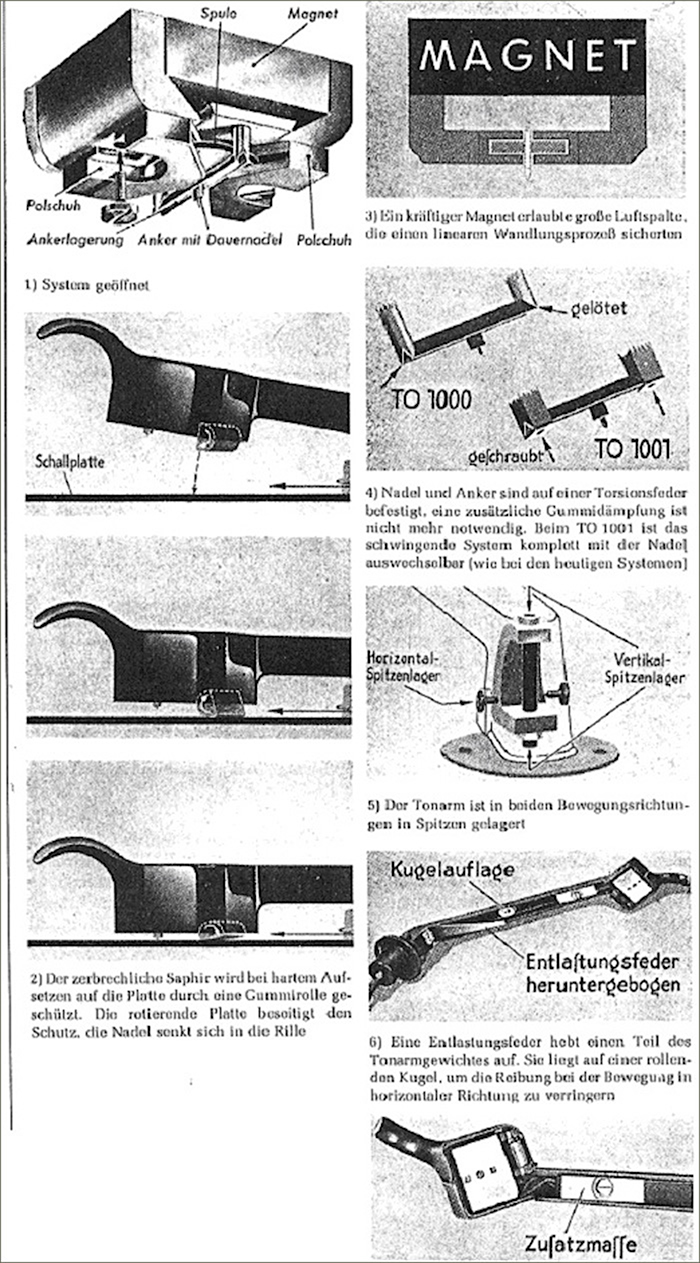

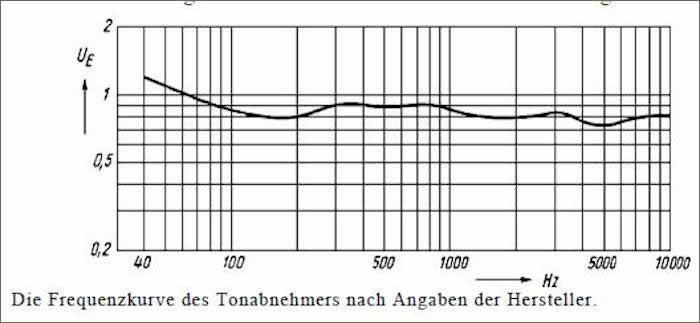

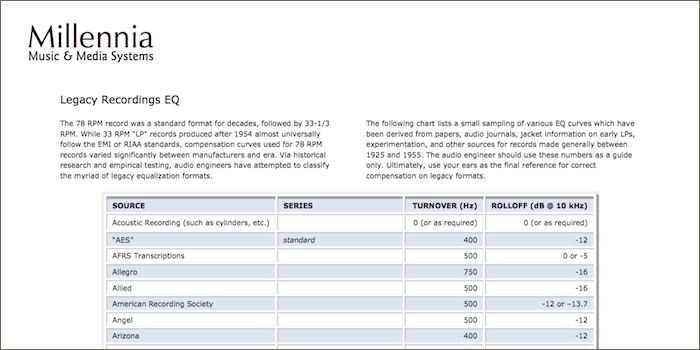

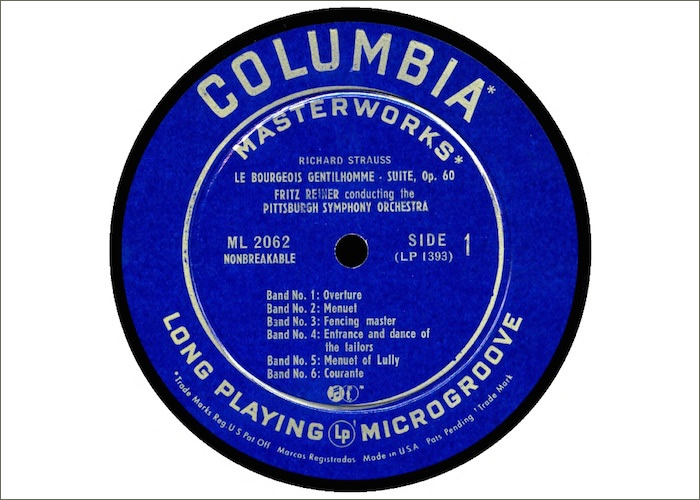

Schellacks können seit den 30er-Jahren mit magnetischen Tonabnehmern abgetastet werden, welche die beim Schneiden vorgenommene Verzerrung besser kompensieren als ein rein mechanisch betriebenes Grammophon. Eine korrekte Entzerrung – komplementär zur Verzerrung vorgenommen, vor dem Schneiden der Schellack – ist für guten Klang unabdingbar. Dass damals daheim die meisten Schellacks mit mechanischen Grammophonen abgespielt wurden, ist für Restaurationen ohne Bedeutung. Es versteht sich von selbst, dass ein Equalizer, der so eingestellt wird, dass er die Aufnahmeentzerrung von Restaurationen ab LP oder CD in der digitalen Domäne von Computer-Audio teilweise verstärkt und teilweise abschwächt, unmöglich klingen muss. Es sind auf dem ganzen Weltmarkt nirgends Restaurationen von TA der EdO zu kaufen, die nicht entzerrt wurden. Die Qualität dieser Entzerrung ist eine andere Frage. Da gibt es enorme Defizite. Der Autor meint dazu ignorierend: …but for our purposes of expanding the frequency range of the music that we play, the above figure is sufficient. Das sagt alles, für jeden der diese Zusammenhänge aus dem Effeff kennt. Denn der Frequenzgang dieses Schneidekopfs war bereits vor 1930 nicht mehr aktuell, also bereits vor Veröffentlichung der zitierten Artikel von damals.

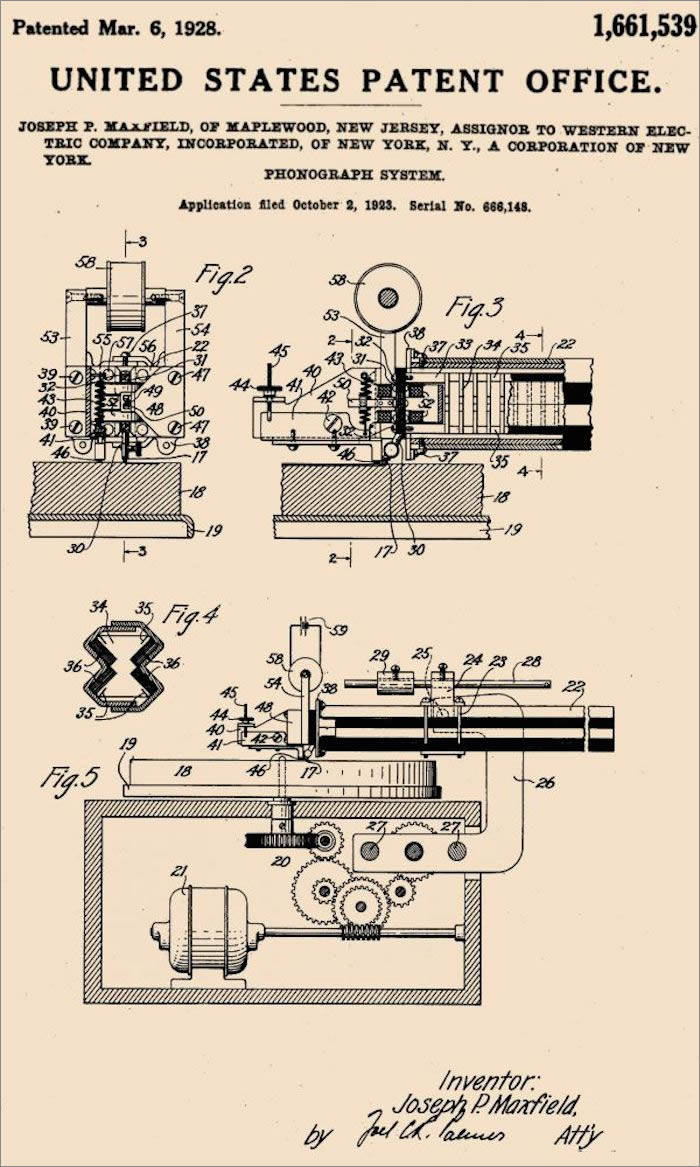

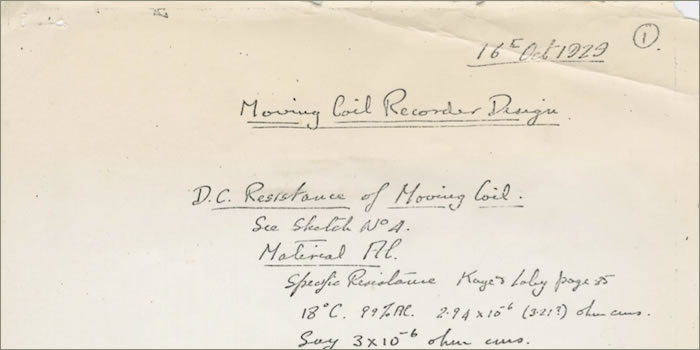

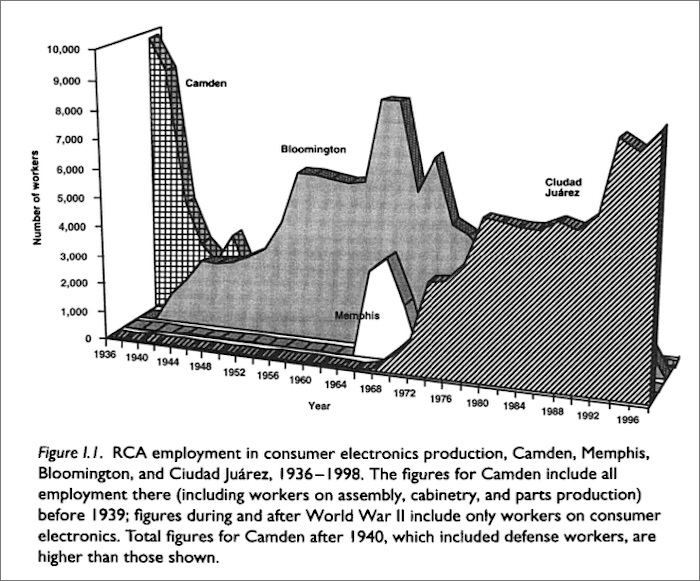

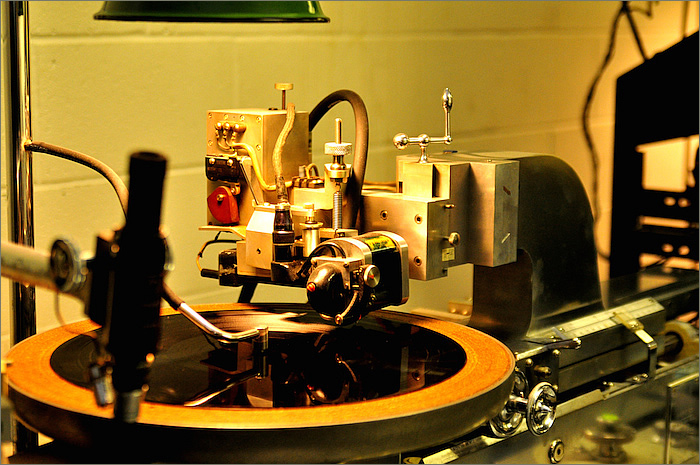

Der abgebildete Frequenzschrieb stammt von einem ganz bestimmten Schneidekopf, dem ersten kommerziell erfolgreichen, elektrischen Schneidekopf der Audio-Geschichte, der in eine komplette, erstmals nach wissenschaftlichen Massstäben akribisch aufeinander abgestimmte Aufnahmekette eingebettet war. Dieser moving iron Schneidekopf WE D85’264 wurde von den Bell-Labs entwickelt und von Western Electric, später Westrex hergestellt und über ERPI, später Greybar ausschliesslich an handverlesene Kunden verleast. Zudem fielen beim Leasing-Nehmer auch noch Lizenzgebühren pro Aufnahme an, und das nicht zu knapp. Das Studio von RCA-Victor in BA hat diesen Schneidekopf von Western-Electric über 20 Jahre lang bis 1947/48 verwendet – aber nur kurz in der vom Autor vorgestellten Entwicklungsstufe. Das Studio von Odeon in BA ist 1931/32 vom WE D85’264 auf Blumleins innovativeren moving coil Schneidekopf von Columbia UK, 1931 mit HMV GB fusioniert zu EMI, umgestiegen, auch um die hohen Lizenzgebühren zu vermeiden.

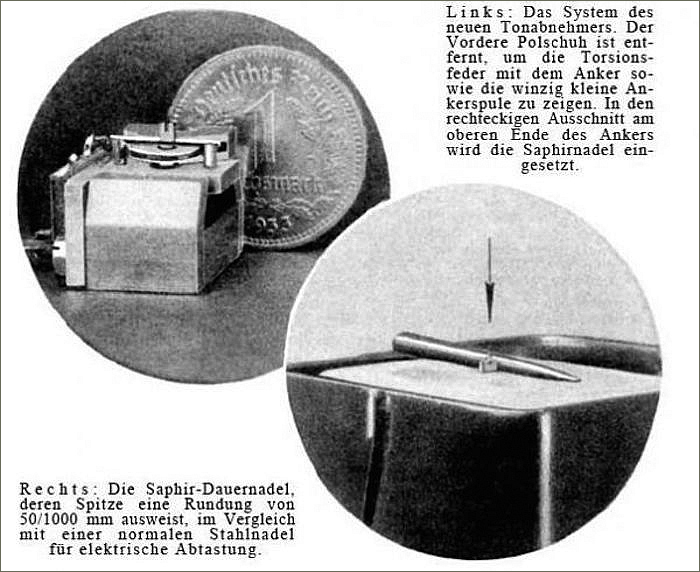

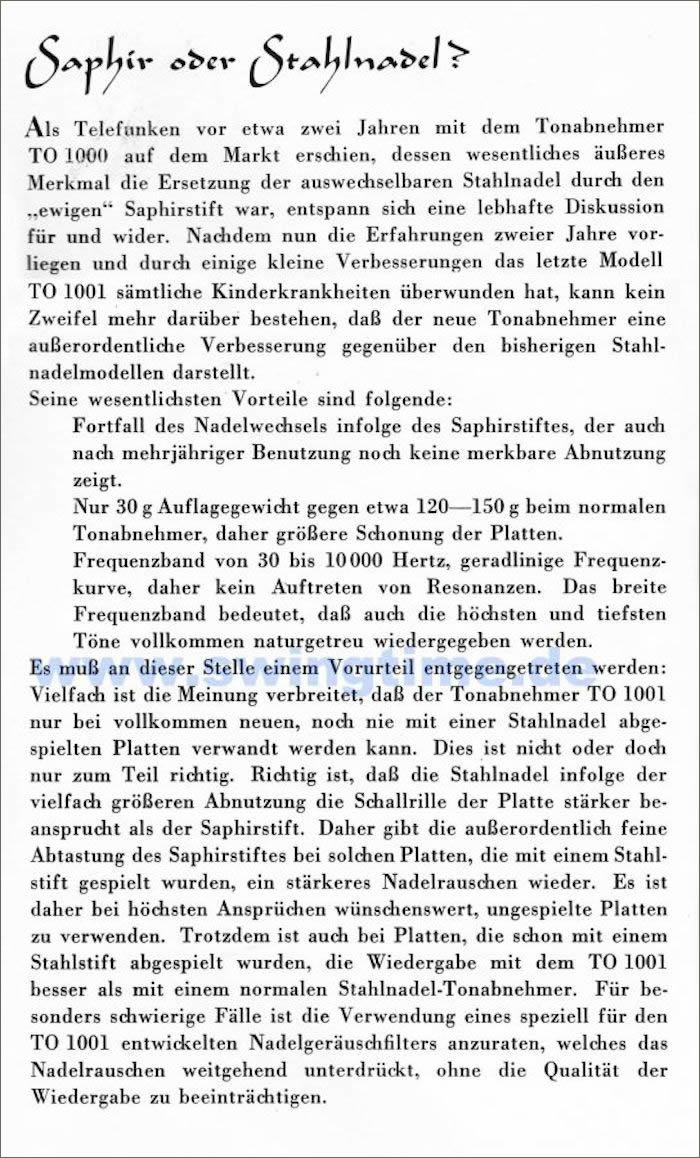

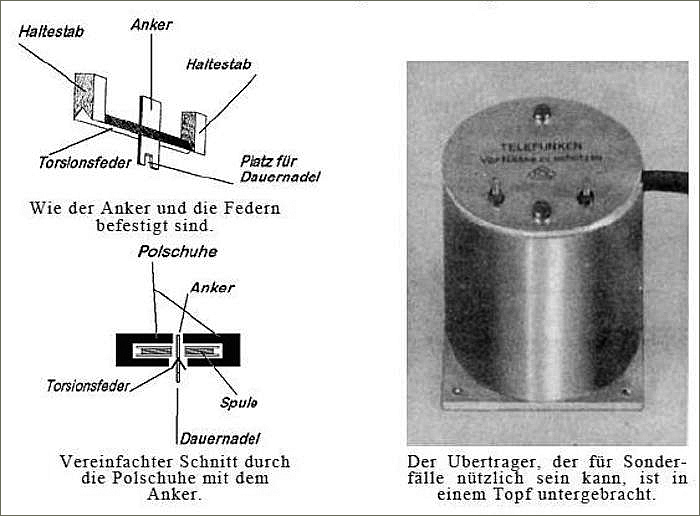

Bereits Ende der 20er-Jahre gab es für Consumer elektrische anstatt mechanische Tonabnehmer für Schellacks – zuerst mit Stahlnadeln und dann mit Nadeln aus Edelsteinen, die sehr viele Abtastvorgänge verkrafteten und die Plattenabnützung markant reduzierten. Mitte der 30er-Jahre kamen Systeme auf den Markt, die nicht mehr mit 40 bis 120 Gramm abtasteten sondern auf Werte unter 20 Gramm kamen, was für den deutlich härteren Materialmix der Schellack optimal ist und 2’000 Abspielvorgänge ohne deutliche Klangverschlechterung ermöglichte. Das für LPs verwendetet Vinyl ist ein Materialmix, der sich beim Abtasten viel schneller verformt. Ausserdem wurden ab Mitte der 30er-Jahre magnetische Tonabnehmer mit Halbedelsteinen als Abtastnadel zahlbar.

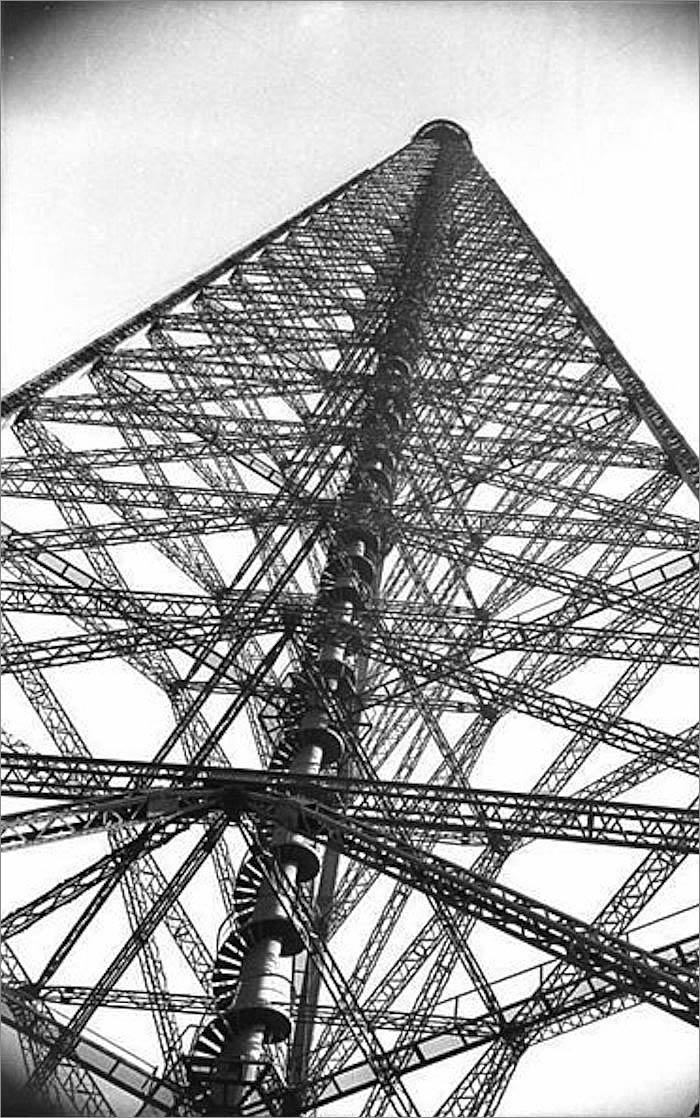

Wie viele Exemplare dieses legendären Schneidekopfs zwischen 1926 und 47 hergestellt wurden, ist nicht überliefert. Aber es werden kaum mehr als 25 Stück pro Jahr gewesen sein. Um das ganze System verwenden zu dürfen, mussten Plattenlabels diese Technik leasen. Ausserdem war eine einmalige Gebühr vorab fällig, die nach heutiger Kaufkraft rund einer Million Euro entspricht. Dazu kamen Lizenzgebühren pro verkaufte Schellackplatte. Das war aber noch nicht alles. Die Plattenlabels mussten sich unabhängig von der Anzahl verkauften Platten dazu verpflichten, eine minimale Lizenzgebühr pro Jahr zu zahlen, die nach heutiger Kaufkraft rund einer halben Million Euro entspricht. WE hat sich seinen mit Patenten abgesicherten Knowhow-Vorsprung damals vergolden lassen, was zur Entwicklung konkurrierender Aufnahmesysteme geführt hat.

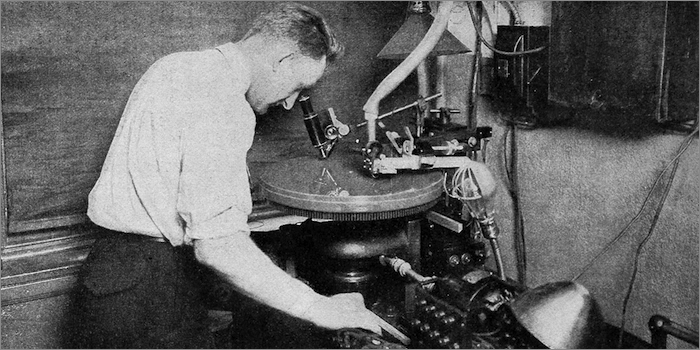

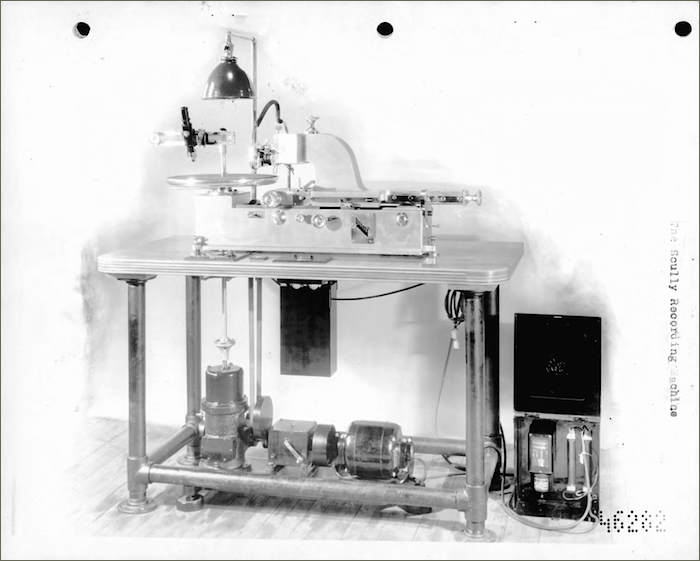

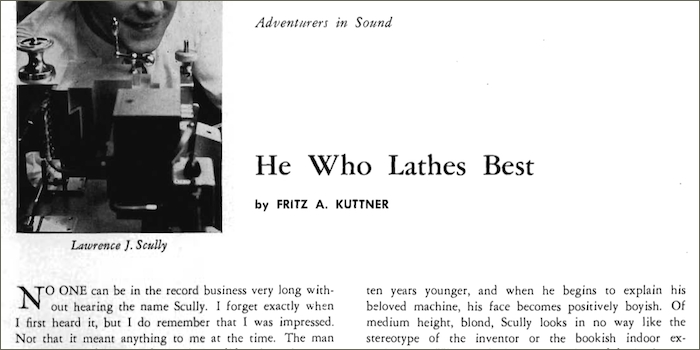

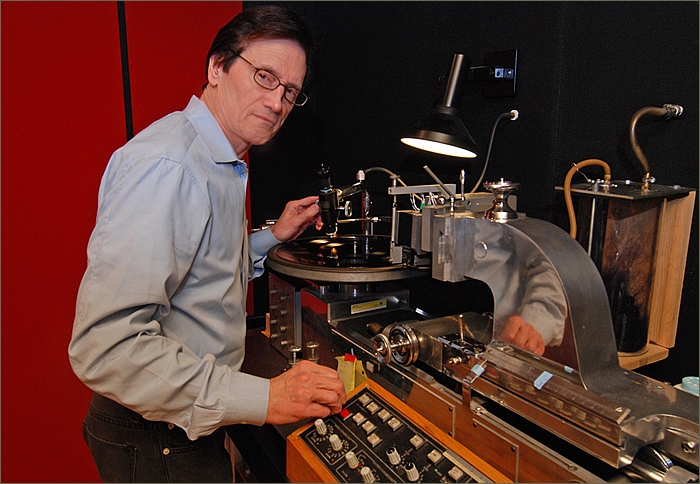

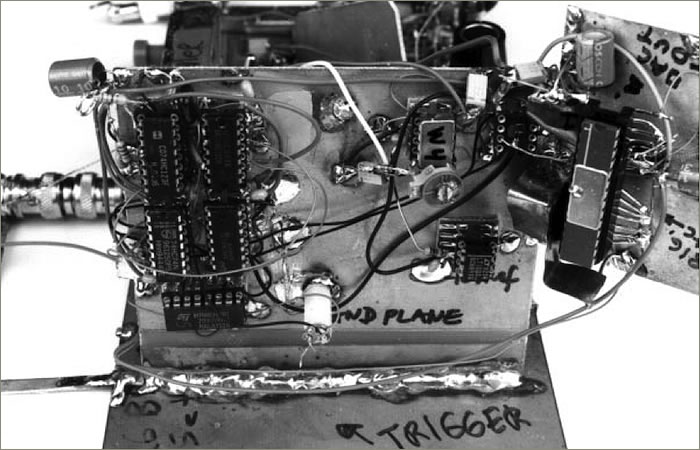

Scully stellte von 1919 bis 1974 Schneidemaschinen her. Obwohl spätestens ab 1950 Neumann innovativere Schneidemaschinen baute, sind heute viele Scullys – oft getweakt und manchmal mit neuem Antrieb und neuer Steuerung versehen – immer noch oder nach einer umfassenden Revision wieder in alter Frische in Betrieb. Die Qualität von Scullys ist heutigen Ansprüchen in jeder Hinsicht gewachsen. Dazu gibt es aber unterschiedliche Ansichten. Ein inzwischen verstorbener Zeitzeuge unter den Tonmeistern, den ich persönlich kannte, war zB der Ansicht, dass er Schallplattenschnitte auf einer Scully gemacht sofort erkennt, weil die Steuerung über Zahnräder zu kleinsten ruckartigen Bewegungen führt. Er hat die preiswerteren, kleineren Schneidemaschinen von Universal bevorzugt, die über Riemen angetrieben wurden, weil er der Ansicht war, dass damit gemachte Aufnahmen besser klingen.

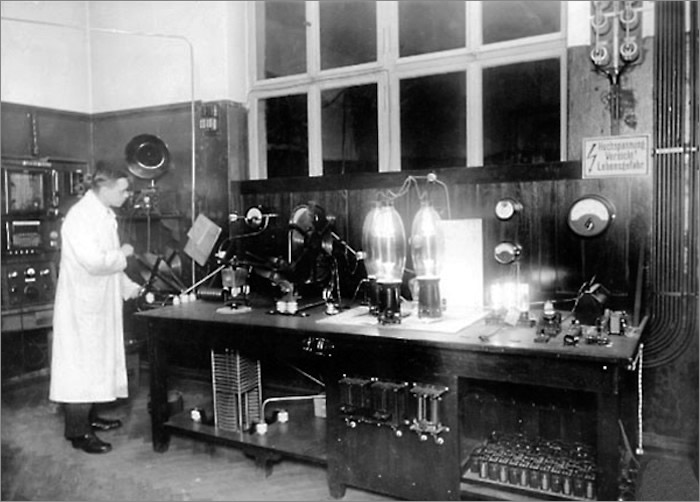

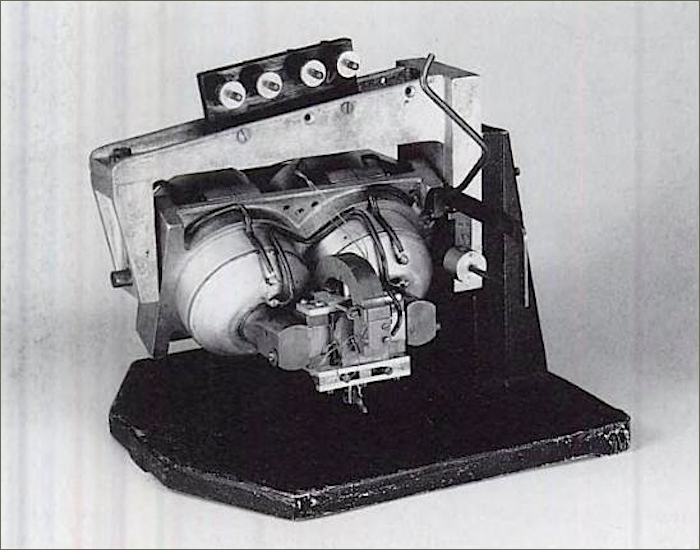

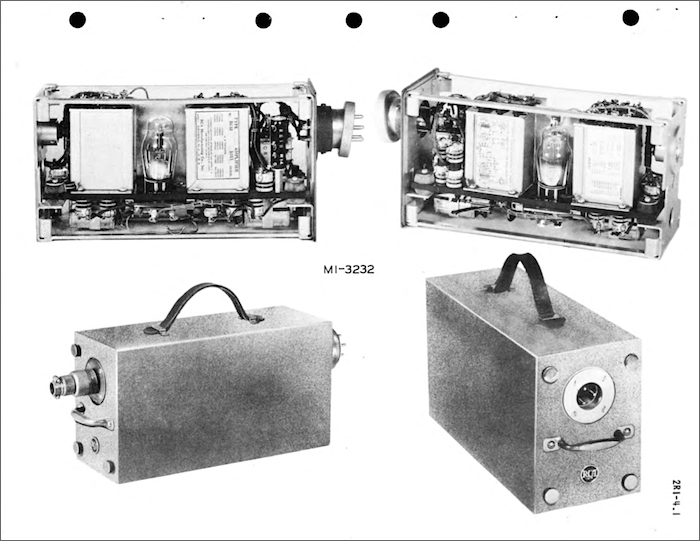

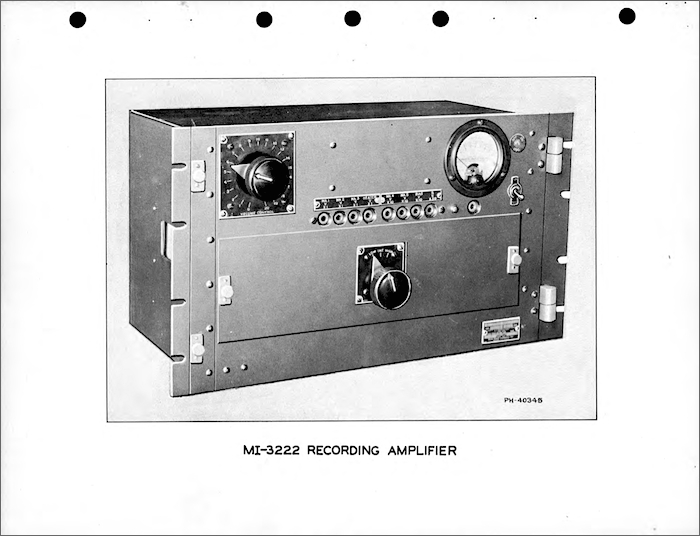

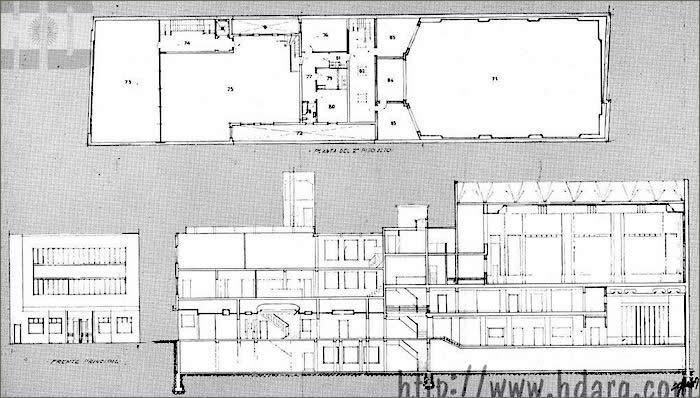

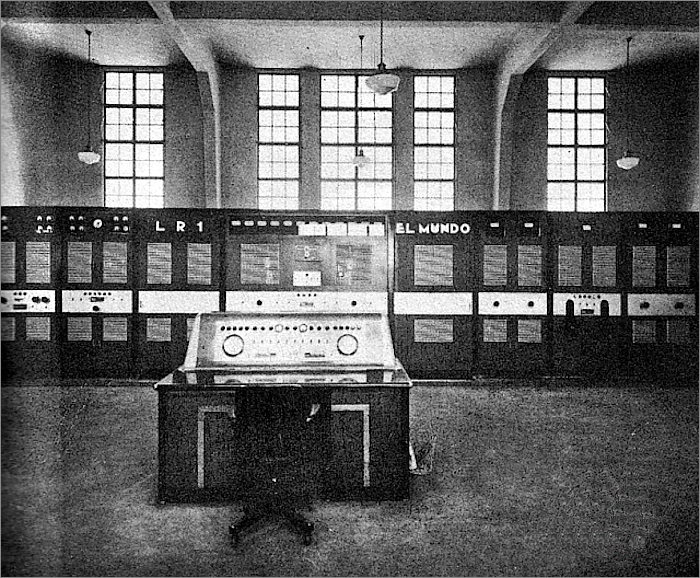

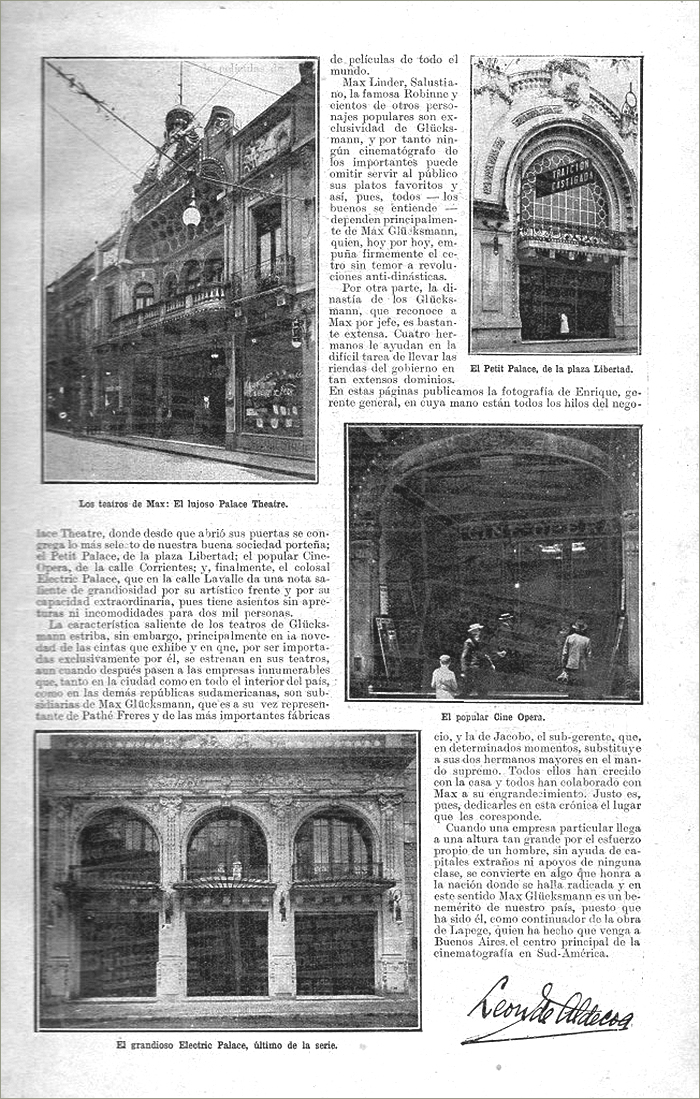

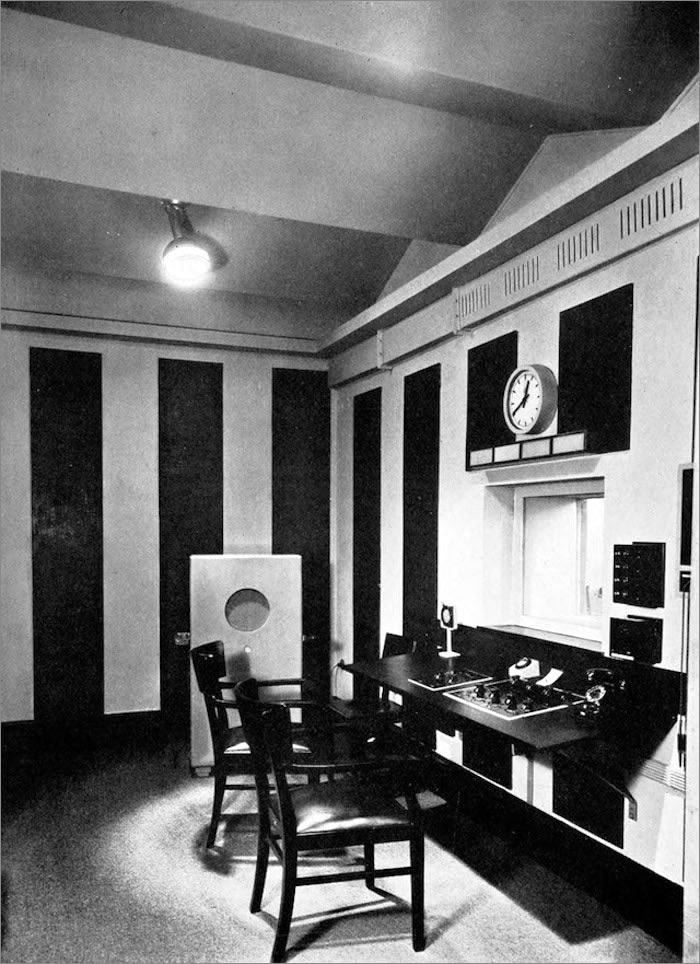

Die in den brandneuen Abbey Road Studios installierte Schneidemaschine mit dazugehörigem Verstärker für das System Blumlein. Der schrankgrosse Schneideverstärker für Blumleins monauralen moving coil Schneidekopf musste anfangs die enorme Ausgangsleistung von 250W bereitstellen, was nur möglich wurde, indem eigens dafür um eine Triode von Marconi herum ein Verstärker entwickelt wurde. Dabei muss es sich um eine Leistungsröhre gehandelt haben, die für Radiosender konzipiert war. Auf dem unteren Foto im rechten Drittel hinter dem Lochblech ist diese gigantische Endstufen-Triode für Radiosender gut zu erkennen. Für diesen Zusammenhang habe ich aber bisher lediglich eine Quelle gefunden. Eine solche Leistung aus einer einzigen Röhre war immer Senderöhren vorbehalten. Später hat man Schneideköpfe entwickelt, deren Schneideverstärker deutlich weniger leisten mussten. Auch der Schneidekopf von WE musste nicht mit so viel Leistung betrieben werden. Anfang der 30er-Jahre waren 20 bis 30W Ausgangsleistung in der Regel das Ende der Fahnenstange – und das auch nur für besonders grosse PA-Installationen.

Zwischen Dezember 1931 und Juli 1932 wurden die Aufnahmeketten von Western Electric und Blumlein in den Abbey Road Studios auf Herz und Nieren geprüft und gegeneinander getestet, bevor der aus Columbia UK und HMV UK neu fusionierte Konzern EMI als Besitzer der Abbey Road Studios aus, wie es damals hiess, klanglichen Gründen für den ganzen Konzern entschied, weltweit nur noch Blumleins konzerninterne Entwicklung einzusetzen. Allerdings war diese Entscheidung sowieso zu erwarten gewesen, weil einzig so die exorbitant hohen Lizenzgebühren für den Einsatz des Schneidekopfs D-85’264 von WE vermieden werden konnten. Aus heutiger, oberflächlicher Sicht überraschend aber inzwischen verifiziert: Beide frühen Entwicklungen, also die Schneideköpfe von WE (und damit RCA-Victor in BA plus Odeon in BA vor 1932) und EMI (und damit Odeon in BA nach 1932) wurden bis Ende 40er- (RCA-Victor BA), Anfang 50er-Jahre (Odeon BA) eingesetzt – auch in den jeweiligen Mutterhäusern in den USA und in GB.

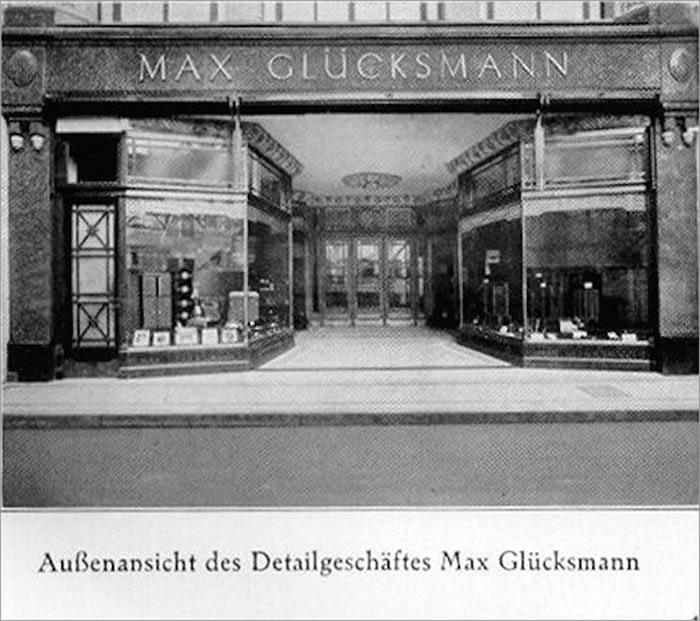

Da Odeon Argentina in BA zuerst eine Kooperation mit Glücksmann in BA und ab Mitte der 30er-Jahre eine reine Tochtergesellschaft von Odeon Deutschland war, aber Odeon von Lindström und Lindström von Columbia UK schon Jahre früher aufgekauft wurde, bestimmte zuerst Lindström, dann Columbia UK und nach der Fusion zu EMI EMI darüber, was Odeon Argentina in BA an Technik einzusetzen hatte. Denn die in den 10er-Jahren von Odeon in BA aufgebaute Plattenfabrik inklusive Aufnahmestudio gehörte immer Odeon, nie Glücksmann.

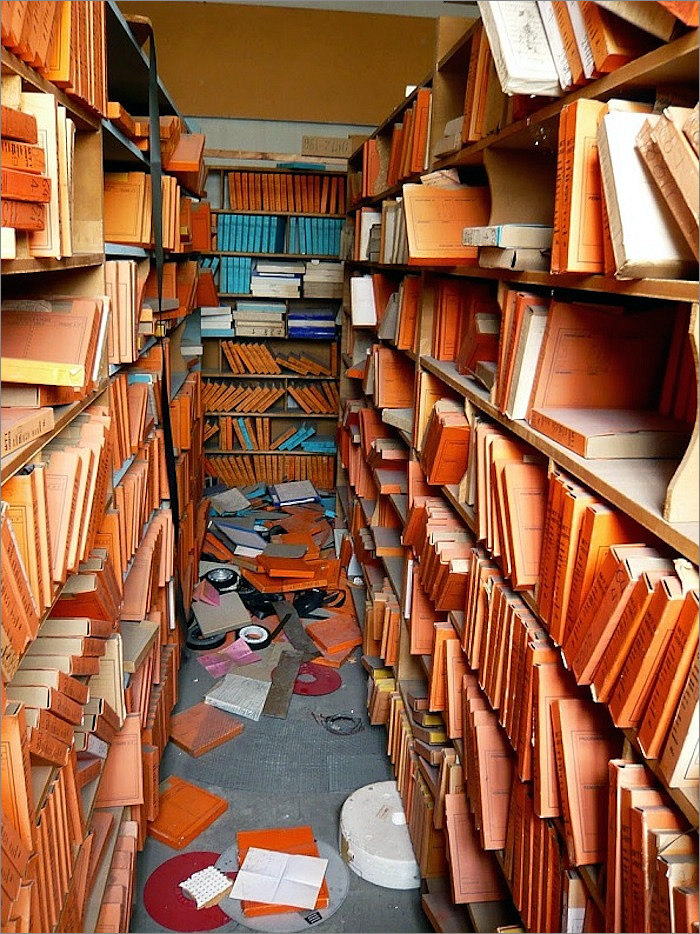

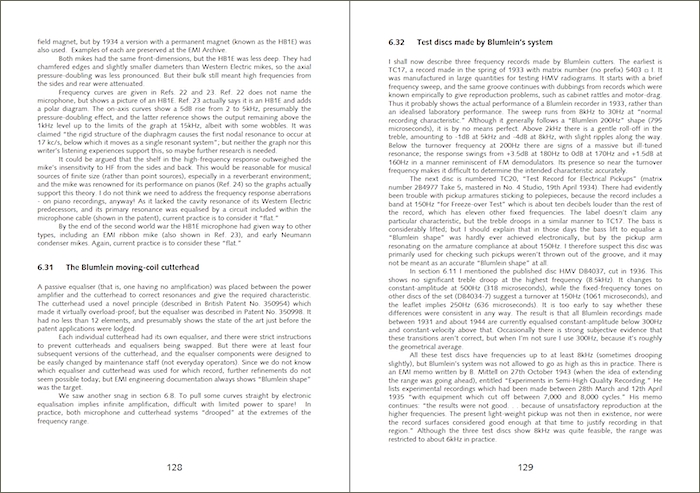

Die Qualitäten der Technik für Schellackkonserven werden seit den 60er-Jahren je länger je mehr unterschätzt. Bis vor 20 Jahren gab es genug Techniker von damals, die jungen Generationen eines Besseren hätten belehren können. Falls die sich die Mühe gemacht hätten zu fragen. Was oft nicht geschehen ist. Die Menge an Wissen, die deshalb inzwischen verloren gegangen ist, ist horrend. Sich dieses Wissen wieder zu beschaffen, damit man irgendwann die Konserven der EdO der künstlerischen Qualität angemessen wiedergeben kann, wird viel Zeit und Geld verschlingen und kann trotzdem nur teilweise gelingen. Falls sich überhaupt jemand finden sollte, der diese Anstrengungen auf sich nimmt.

Der Autor liefert in Bezug auf diesen für seine Argumentation zentralen Frequenzschrieb – auf dem seine komplette Argumentation zum Thema Equalizer fusst – also missverständliche Information aus vierter(!) Hand: Der Artikel um 1930 wurde von einem Journalisten geschrieben, der einige white paper auswertete und über die eine oder andere Insider-Information verfügte, aber bereits Missverständnisse einfliessen liess, weil er nicht die Quelle der Information war und nicht wusste, dass dieser Schneidekopf in überarbeiteter Form längst mehr konnte. Dieser Artikel wird heute in einem akademischen Blog zitiert, ohne dessen Ungenauigkeiten zu korrigieren. Darauf wiederum verweist der Autor, ohne die bereits aufgelaufenen Missverständnisse einer Kaskade von drei Quellen zu benennen. Statt dessen fügt er neue Missverständnisse hinzu, weil er falsche Schlussfolgerungen zieht.

Im damaligen Aufnahmestudio waren mehrere Geräte in die Aufnahmekette eingeschlauft. Dieser Frequenzschrieb beinhaltet daher eine viel zu grosse Vereinfachung, als dass man daraus brauchbare Schlüsse ziehen könnte, wie Restaurationen der letzten 50 Jahre verbessert werden könnten, da er auf die Defizite der Restaurationen (in Bezug auf den negativen Einfluss seit über 50 Jahren primäre Fehlerquelle) gar nicht eingeht. Er ortet die Defizite fälschlicherweise bei den Schellack-Aufnahmen (in Bezug auf den negativen Einfluss seit über 50 Jahren sekundäre Fehlerquelle).

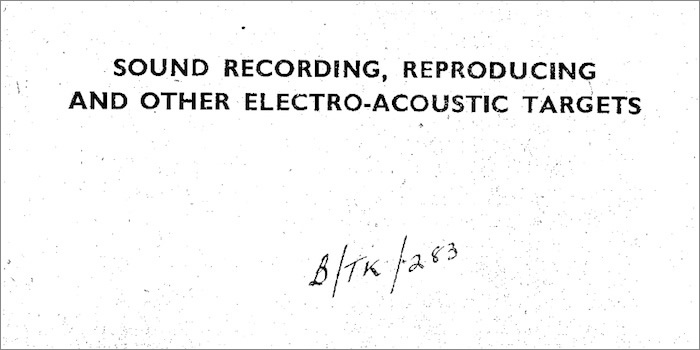

Zwischen 1920 und 1950 verlief die technische Entwicklung von Audiotechnik ausgesprochen rasant. Wer neomanisch gestrickt ist, zieht diese Tatsache heute natürlich nicht in Betracht. Aber wer die Vergangenheit nicht kennt, kann die Gegenwart nicht begreifen und die Zukunft nicht gestalten. Und wer die Vergangenheit verleugnet, ist dazu verdammt, immer wieder dieselben Fehler zu machen und sich im Kreis zu drehen wie ein Hamster im Rad. Zukunft bedingt Herkunft. Viele Details der Audiotechnik wurden zudem vor 1950 nur fragmentarisch schriftlich dokumentiert oder firmenintern strikt unter Verschluss gehalten, weil Entwickler, Hersteller und Operateure fürchteten, dass ihr technologischer Vorsprung ausspioniert werden könnte. Es gibt zB nur wenige Fotos, die das tatsächliche Setup in Tonstudios zeigen, weil die Positionierung der Mikros beinahe immer verändert wurde, bevor ein Fotograf das Studio betreten durfte. Industriespionage war bereits damals ein grosses Thema. Denn es ging auf Grund der anfallenden Lizenzgebühren für Schneideköpfe um richtig viel Geld. In diesem Zusammenhang konnte jedes Detail im ganzen Aufnahmeprozess erfolgsmitentscheidend sein. Damit sind in der Plattenindustrie ganze Firmenimperien aufgebaut worden. In diesen Patenten hat eine Sparte von big media seinen Ursprung.

Unterschätzte Aufnahmetechnik

Wer Thread, Website, Artikel-Zitate und ein wenig Quellenmaterial zu diesem Frequenzschrieb aufmerksam studiert entdeckt also sofort, wo das Problem liegt. Auf diesem Frequenzschrieb aufbauend Schlussfolgerungen zu treffen führt aber noch aus ganz anderen Gründen in die Irre. Ich kann die nun folgende Steigerung der Komplexität der Zusammenhänge keinem Leser ersparen. Es geht um Fakten, die weitreichende Konsequenzen haben.

Dieser ungefähre Frequenzschrieb eines Schneidekopfs war nur für die Jahre 1925–27 aktuell. Bereits 1928 war dieser Schneidekopf von den Bell Labs überarbeitet worden. Diesen Schneidekopf gab es bis 1947 in mindestens 4 Entwicklungsstufen, wobei die letzte vermutlich um 1938 herum erreicht wurde. Allerdings gibt es zu dieser Jahreszahl unterschiedliche Ansichten. Copeland zB, der DIE Restaurations-Bibel zu analoger Audiorestauration geschrieben hat, verortet die letzte Ausbaustufe auf Mitte der 40er-Jahre. Wir müssen aber davon ausgehen, dass dieser Schritt von manchen Operateuren bereits bis zu einem Jahrzehnt früher angewendet wurde, weil er technisch überraschend einfach zu bewerkstelligen war.

Damals waren die Bell Labs der wichtigste think tank der USA, aus dem später mehrere Nobelpreisträger hervorgingen. Allerdings sind schriftlich festgehaltene Werte im Fall des D-85’264 eher theoretischer Natur. Die Kleinstserienfertigung des D-85’264 beinhaltete zu grosse Streuungen der Spezifikationen. Insbesondere alterte die mechanische Resonanzdämpfung des Schneidekopfs aus Gummi und dessen Fixierung in der Armatur rasant. Daher mussten Tonmeister diesen Schneidekopf für gleichbleibende Resultate häufig fabrikneu nicht nur kalibrieren, sondern tweaken, was ziemliches Fingerspitzengefühl erforderte.

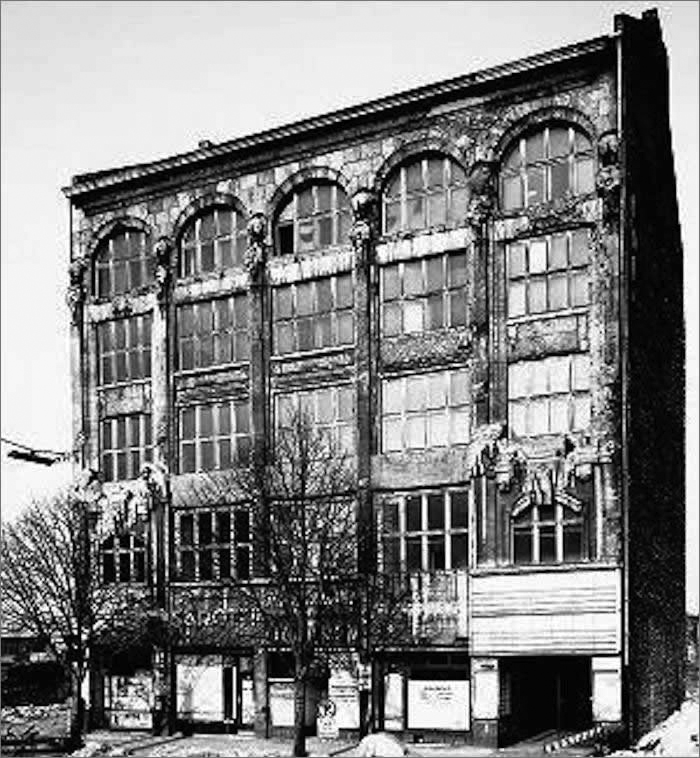

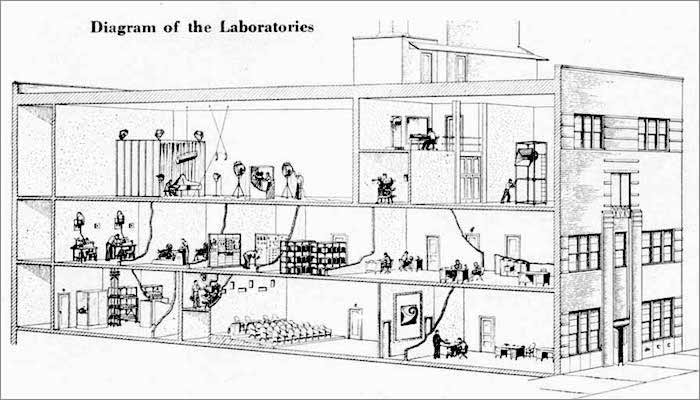

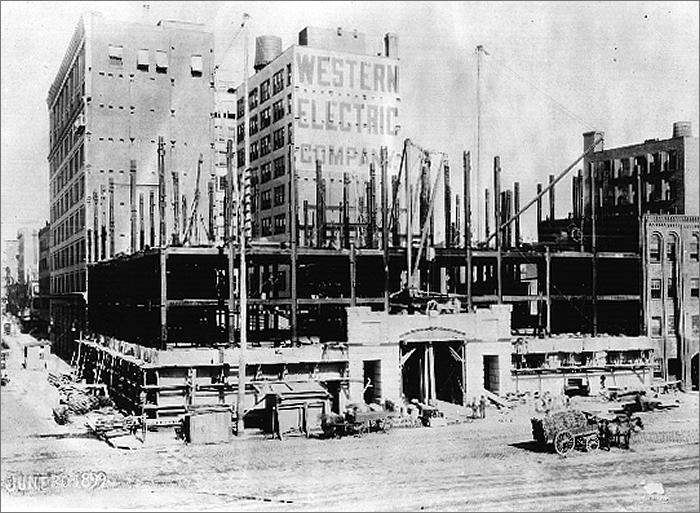

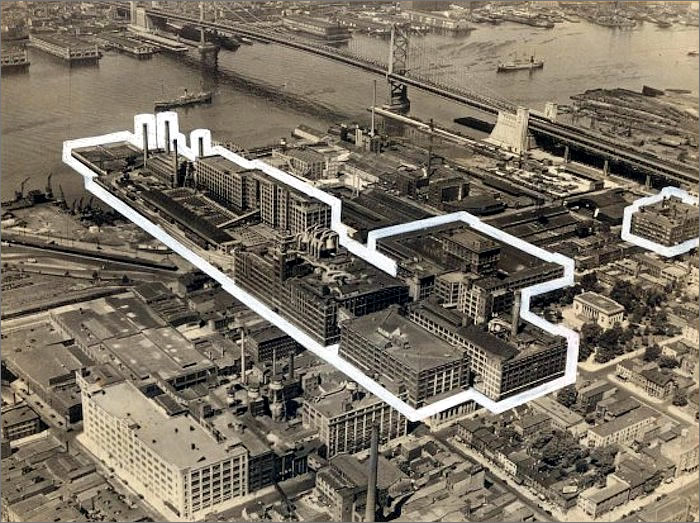

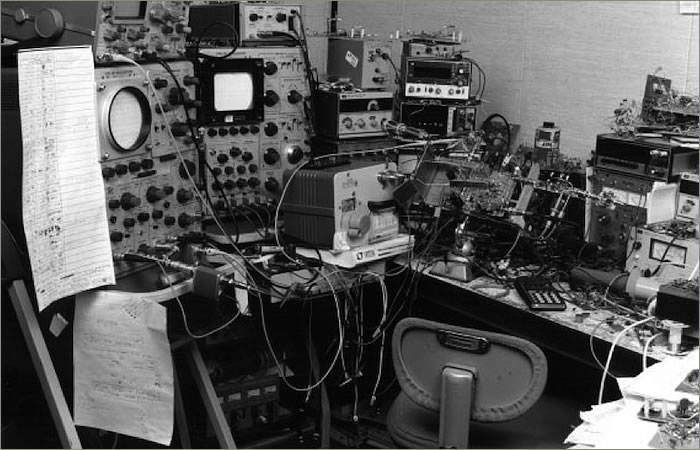

1925 wurden die Forschungsabteilungen der Firmen Western Electric (gegründet 1869) und der Bell Telephone Company (gegründet 1874), deren Muttergesellschaft später zum berüchtigten Monopol-Kraken AT&T mutierte, unter dem Namen Bell Laboratories zusammengelegt. Das war damals der wichtigste think tank der USA mit 3600 Mitarbeitern im Jahr 1925, in dem Grundlagenforschung und konkrete Anwendungen für die Audio-Industrie, die damals noch vor ihrer Geburtsstunde stand, nur ein kleiner Teil der abgedeckten Disziplinen war. Hier haben neben unzähligen anderen Ingenieuren auch Maxwell, Harrison, Frederick, Wende und Thuras entwickelt. Das Gebäude wurde 1899 erbaut. Die enormen Erfolge der Labs damals sind auch Jewett – Leiter der Labs von 1925 bis 40 – zu verdanken, der im Gegensatz zB zu Whitney als Leiter bei General Electric immer darauf bestanden hat, dass in den Bell Labs ein motivierendes, humanes Betriebsklima mit grosser kreativer Freiheit gepflegt wurde. An der Rückseite verlief eine Hochbahn, die längst demontiert ist. Heute ist das Gebäude in Lofts unterteilt und einige Kulturinstitutionen haben dort auch Platz gefunden.

Anfang der 40er-Jahre dislozierte der grösste Teil der Labs ins benachbarte New Jersey, in einen um ein Vielfaches grösseren Komplex in Murray Hill. Anstelle von Gruppenfotos mit familiärem Charakter mussten für Fotos ein Teil der Forscher in Murray Hill Spalier stehen. Spätestens ab dann waren die Labs Teil des militärisch-industriellen Komplexes der USA und platzen schon bald wieder aus allen Nähten. Also wurden weitere, ebenso grosse Labor-Komplexe in anderen Bundesstaaten aus dem Boden gestampft. Das Ganze gipfelte darin, dass ein Teil der Labs in Murray Hill radioaktiv kontaminiert wurde. Die Bell Labs dort und anderswo waren jahrzehntelang in geheime nukleare Forschungsprojekte verstrickt.

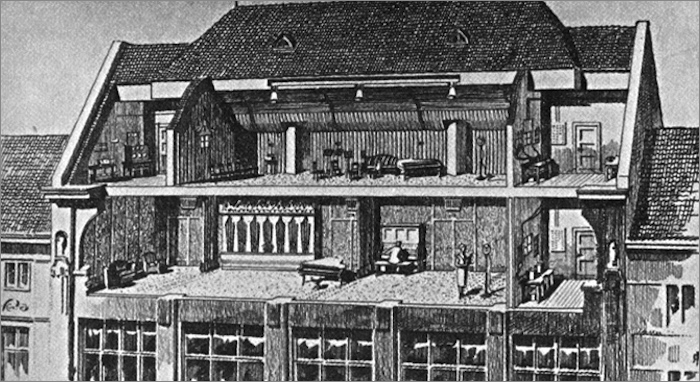

Die sehr viel kleinere Entwicklungsabteilung von EMI wurde westlich von London in Hayes/GB aufgebaut. Das erste Foto stammt aus dem Jahr 1933. Die ersten Gebäude auf diesem Gelände entstanden bereits 1907. Dort hat unter anderen Blumlein entwickelt – aber nicht sein monaurales, sondern sein stereophones System. Das für uns relevante, monaurale entstand im Mutterhaus von Columbia GB, vor der Fusion von HMV GB und Columbia GB zu EMI. Das zweite Foto zeigt einen Teil des EMI-Komplexes in Hayes im Westen Londons in den Jahren grösster Ausdehnung – mit EMIs Entwicklungsabteilung ganz rechts. Seit dem 2. Weltkrieg war auch dieses Labor Teil des militärisch-industriellen Komplexes Grossbritanniens.

Die notorisch viel zu grossen Qualitätsstreuungen in der Kleinstserienproduktion führte dazu, dass Könner unter den Tontechnikern mit dem Tweaken dieses Schneidekopfs früh Erfahrungen sammelten und daher vereinzelt bereits um 1932 herum Frequenzen von 10 bis 12kHz mit moderatem Pegelabfall zu schneiden vermochten. Davon ist in den offiziellen Unterlagen des Herstellers natürlich nichts zu finden. Solche Fakten erfährt man nur, wenn man mit Zeitzeugen unter den Aufnahmetechnikern spricht.

Um zu verstehen, warum der Einsatz eines Equalizers die Defizite der Restaurationen nicht lösen kann – denn unsachgemässer Equalizer-Gebrauch ist das Problem, nicht die Aufnahmen von damals, schliesslich haben sich die Gesetze der Physik in den letzten 100 Jahren kaum verändert und die Ingenieure von damals waren keine Dummköpfe –, muss man sehr viel mehr über die Aufnahmetechnik von damals und das Restaurationsniveau im TA mit Musik der EdO der letzten 50 Jahre verstehen als der Autor und die Profis der Sour Peach Studios für sich in Anspruch nehmen können.

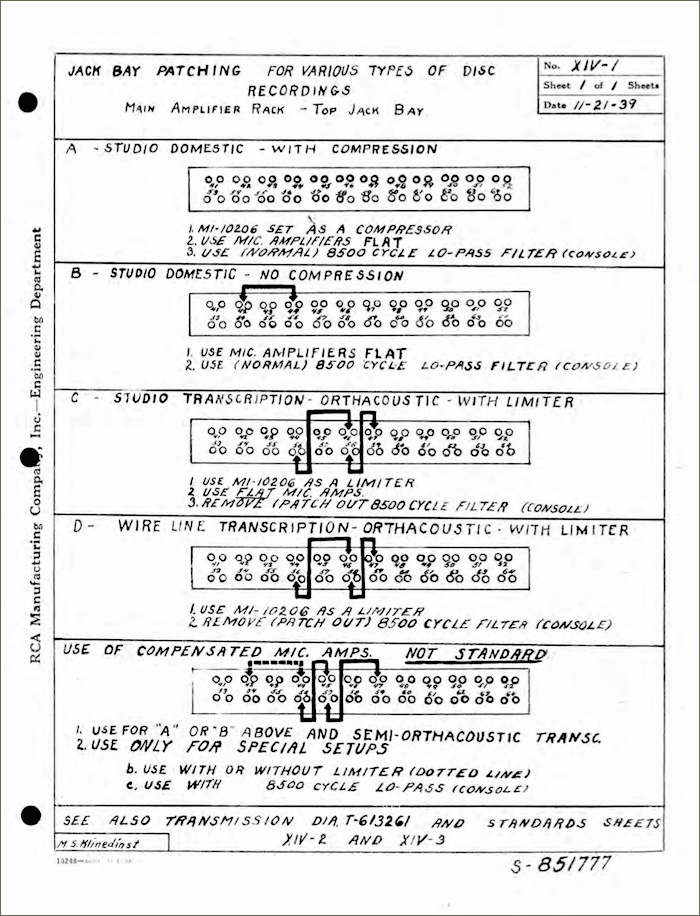

Der Frequenzgang über die ganze Aufnahmekette hinweg wurde neben dem Schneidekopf von einer ganzen Reihe weiterer Geräte beeinflusst: im Minimum waren das Mikrophone, Mikrophonverstärker, Mischpult (teils modular aufgebaut), Verstärker-Rack mit Schneideverstärker plus Schneidekopf. Ab wann genau in dieser Aufnahmekette zusätzlich Equalizer und Kompressoren oder Limiter zum Einsatz kamen, habe ich bis heute nicht herausfinden können. Ich weiss lediglich, dass das mit Sicherheit ab Anfang der 30er-Jahre gemacht wurde. Vorreiter dabei war die Filmindustrie mit ihren Dynamikproblemen. Aber ich weiss nicht in welchem Umfang. Einzelne Schneideköpfe vom Typ WE 85’264 haben überlebt. Aber die dazugehörigen Schneideverstärker, im Gegensatz zu Monitoren und Wiedergabeverstärkern, nicht. Copeland schreibt, dass die, weil geleased, nach Ablauf der Vertragsgsdauer alle zurück zum Hersteller gingen und dort entsorgt wurden, damit das Knowhow dahinter nicht öffentlich wird. Logisch scheint mir das nicht, weil auch die Schneideköpfe nur geleased werden konnten. Mit den Jahren wurden jedenfalls zusätzliche Geräte eingeschlauft. Nur wenn man Frequenzgang plus Phasenverlauf(!) all dieser Geräte berücksichtigen würde, ergäbe das eine Grundlage für eine Diskussion über Konsequenzen und Möglichkeiten einer Korrektur heute.

Diesem immer noch recht überschaubaren Vorgehen stehen in der Praxis weitere Tatsachen im Weg. Und die haben es in sich. Leider ist es so, dass einmal gemachte Fehler in Bezug auf die erste notwendige Beeinflussung des Frequenzgangs einer Restauration sich danach nicht mehr beheben lassen: weder mit einem Equalizer, noch mit einem Algorithmus. Nach diesem ersten Schritt lassen sich nur noch minimale Verbesserungen erzielen. Meist resultiert aus einem Vorgehen, welches diese Zusammenhänge ignoriert wie beim Autor, klangliche Verschlimmbesserung.

Grundsätzlich kann jeder Ingenieur die Ursachen dahinter rechnerisch nachvollziehen, weil dahinter banale Physik steckt. In Wirklichkeit sind die genauen Zusammenhänge dazu sogar vielen Tontechnikern im Genre Klassik heute nicht mehr bekannt. Das hat viel mit Neomanie zu tun. Man muss sich sehr ausführlich mit einem Restaurations-Crack austauschen und mit einem Entwickler-Crack von Entzerrvorverstärkern, um diesen Einschränkungen als Amateur auf die Spur zu kommen und die gegenseitigen Abhängigkeiten allmählich zu verstehen. Ich habe dafür Jahre gebraucht, weil ich keine genmutante Kreuzung aus Ingenieur und Tonmeister bin. Und trotzdem habe ich heute immer noch viele Fragen.

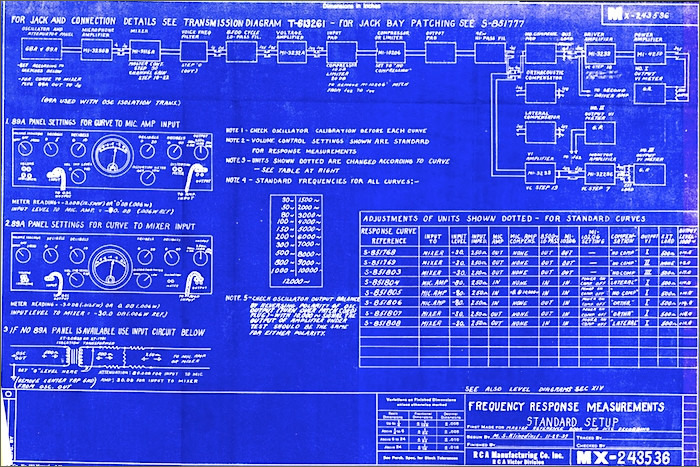

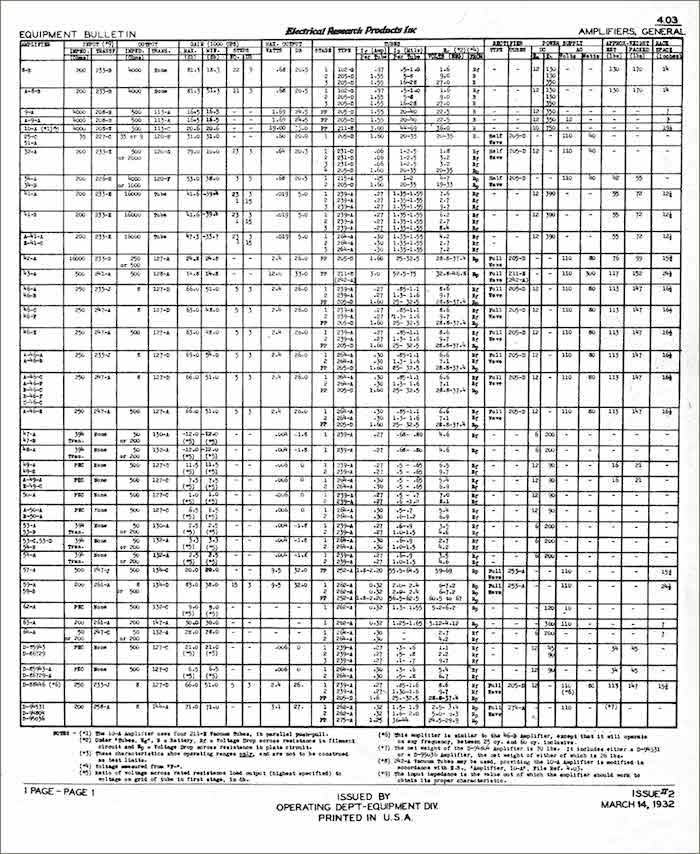

Fakten anstatt Trollfutter

Im Studio von RCA/Victor Argentina in BA verwendeten die Tontechniker für Schellack-Aufnahmen eine rund 400 Seiten umfassende, englischsprachige technische Referenz, die 1939/40 für das Direktschnittverfahren auf Schellack letztmals vom Mutterhaus in Camden/USA völlig neu erstellt und dann nur noch ergänzt wurde. Das war deren technische Bibel. Dort wird der Aufbau beinahe aller Komponenten, deren Verwendung und Zusammenbau detailliert dokumentiert. Sogar Test-, Kalibrations- und Wartungszyklen werden darin definiert, für täglich, wöchentlich und monatlich zu erledigende Arbeiten – inklusive Arbeitsblättern, in die man die Messwerte eintragen konnte, um sie sofort auszuwerten und zu dokumentieren. Das Diagramm aus dieser Referenz ist weniger Momentaufnahme, mehr unternehmensinterne Vorschrift. Sie zeigt, mit welcher aufnahmeverfahrenstechnischen Verzerrung gemäss Vorgaben der Entwicklungsabteilung des Labels in Camden/USA Schellacks auch in Argentinien zu schneiden waren. Gesteuert wurde diese Frequenzkurve durch Wahl und Einstellung von Mikrophon, Mikrophonverstärker, Mischpult, allfällig eingeschlaufte Geräte wie Equalizer, Kompressor oder Limiter, Schneideverstärker und Schneidekopf D-85’264.

Das sind also jene Daten, über die der Autor mangels Sorgfalt bei der Recherche nicht verfügte. Aber aufgepasst: Die Angaben im Diagramm sind Vorgaben des Mutterhauses, auf denen ein Techniker ab 1,5kHz einen deutlich veränderten Frequenzgang eingetragen hat. Mit ziemlicher Sicherheit, weil er die Aufnahmekette ohne Rücksprache mit dem Mutterhaus verändert hat. Eine solche Korrektur ist klanglich gut zu hören. Zudem zeigt der Frequenzschrieb auch den Verlauf des Frequenzgangs bei ausgeschaltetem low pass. Ob das Studio in BA sich an die Vorgaben von Chefentwickler Pulley in Camden/USA gehalten hat, wissen wir nicht. Ob der low pass für Schellack-Aufnahmen immer eingeschaltet war, wissen wir nicht. Ich zumindest kann eine dermassen abrupte Beschneidung von Obertönen auf Spektralanalysen von Schellacks aus diesen Jahren ab 8kHz nicht nachvollziehen. Um das abschliessend zu beurteilen, müsste ich mir aber mehr Zeit nehmen als ich dieser Tage freizuschaufeln vermag. Daher muss hier ein Fragezeichen stehen bleiben.

Abgesehen von ziemlich freigeistig organisierten think tanks wie den Bell Labs war die Arbeitswelt eines Ingenieurs oder Operateurs in den Firmenkonglomeraten der Plattenlabels damals ausgesprochen hierarchisch organisiert. Bei den Plattenfirmen waren Aufnahmetechniker bis Anfang der 40er-Jahre häufig mehr technische Operateure. Das heisst, ihr Betätigungsfeld war recht eng definiert und nur dort hatten sie das Sagen, konnten Musiker sich nicht einmischen. Tontechniker wurden kaum in kreative Prozesse eingebunden und sie gestalteten sie nicht wie später mit. Wenn man mit Zeitzeugen spricht, wird aber klar, das diese Ingenieure trotzdem häufig nicht das gemacht haben, was ihnen ihr Chef vor Ort ohne profundes technisches Knowhow oder ein tausende von Kilometern entfernter Supervisor mit profundem technischem Knowhow vorgeschrieben haben. Im Fall des Schneidekopfs D-85’264 waren Tontechniker sogar dazu gezwungen zu experimentieren, weil grosse Streuungen der Spezifikationen in der Kleinstserienfertigung sie mit Schneideköpfen konfrontierten, die getweakt werden mussten, um die Qualitätsvorgaben des Labels einzuhalten. Davon steht natürlich nichts in den offiziellen Unterlagen des Herstellers. Vom offiziell genehmigten tweak zum tweak nach eigenem Gusto war es dann nur noch ein vermeintlicher Schritt. Aber vor allem einer, der viel spannender war, als lediglich ausführendes Organ zu sein.

Diese Modifikationen umfassten damals ein weites Feld. Experimentiert wurde unter anderem mit gekürzten Armaturen, erleichterten Armaturen, anderen Materialien, Materialmischungen für die mechanische Dämpfung, erhöhter Stromstärke für die Magnetspule, Wachs anstelle von Schellack für die Befestigung des Schneidestichels, Modifikation der Rückholfedern weit über die vom Hersteller vorgegebenen Werte hinaus und natürlich jeder Art von Modifikation an den Regelgliedern, welche die Aufnahmeverzerrung definierten. Ab wann solche Regelglieder in BA in Einsatz waren, habe ich aber bis heute nicht klären können. Aus heutiger Sicht frappant ist die Tatsache, dass der D-85’264 mit so geringen Modulations-Verzerrungen glänzte, dass nicht mal Schneideköpfe aus den 70er-Jahren in diesem Aspekt mithalten konnten.

Weil die Lager der Labels und die Regale der Händler voller Schellacks mit akustischen Aufnahmen waren, als die ersten Labels die Technik für das neue elektrische Aufnahmverfahren in Betrieb nahmen, wurde die Klangqualität der neuen Technologie zwei Jahre lang öffentlich kleingeredet, um den Abverkauf der obsolet gewordenen Lagerware nicht zu behindern. Die damals führenden Labels Columbia (dazu gehörte auch Lindström und damit Odeon) und RCA-Victor sind aber noch einen Schritt weiter gegangen. Dazu haben sie ein Kartell gebildet und zwei, drei Jahre lang die Aufnahmequalität des neuen Prozesses aktiv verschlechtert, indem für die Aufnahmen Bässe und Höhen absichtlich beschnitten wurden. Wer sich die Zeit nimmt, Pressungen von Testplatten aus den Jahren 1924–26, die überlebt haben, mit veröffentlichten Schellacks zu vergleichen, kommt diesen Manipulationen schnell auf die Spur. Der von den Bell Labs bereits 1928 vorgestellte Fortschritt eines sogenannt experimentellen Schneidekopfs ist daher nichts anderes als die Vorstellung des drei Jahre lang bewusst zurück gehaltenen Innovationsstandards von 1925. Das dafür notwendige Knowhow basiert auf Grundlagenforschung, die spätestens 1925 abgeschlossen war.

Die Krux mit der Entzerrung

Nun erkläre ich, warum der Ansatz des Autors auch dann nicht funktionieren würde, wenn er Frequenzgang und Phasenlage über die ganze Aufnahmekette hinweg, inklusive Ver- und Entzerrung, berücksichtigt hätte.

Jede Restauration ab Schellack – nur damit lassen sich möglichst gute Restaurationen realisieren, wo die Metallmaster nicht mehr zur Verfügung stehen – beinhaltet nach der mehrstufigen Reinigung der Schellack und dem Erstellen eines Arbeitstransfers für vorbereitende Entscheidungen in einem synchronen Schritt den eigentlichen Transfer (1) der Schellack mit technischer Entzerrung (2) – diese macht die vor dem Schneiden des Masters vorgenommene aufnahmeverfahrenstechnisch bedingte, also technische Verzerrung zwecks optimaler Konservierung des Frequenzspektrums auf diesem Speichermedium rückgängig –, plus Konvertierung (3), analog zu digital und speichern (4) dieser Daten. Nur mit diesem sofortigen Wechsel in die digitale Domäne vermeidet man, dass die Schwächen mehrerer analoger Konservenformate (Schellack plus Bandmaschine) kumulieren.

Die Güte dieses elementaren Multischritts entscheidet über 80% der klanglichen Qualität einer Restauration. Die restlichen Schritte sind nicht ohne und verschlingen reichlich Zeit. Sie sind aber verlorene Arbeitszeit und Liebesmühe, falls der erst Schritt nicht mit grösster Sorgfalt von einem absoluten Restaurations-Crack vorgenommen wird.

Da die vor dem Schneiden des Wachs-Masters vorgenommene technische Verzerrung des Frequenzgangs während der Schellack-Ära niemals standardisiert war – die Labels hielten ihre proprietären Standards geheim (was für Plattenkäufer mit guter Technik daheim eine absurde Situation war), änderten sie immer wieder, manche Aufnahmetechniker hielten sich nicht immer an diese Vorgaben ihrer Arbeitgeber oder arbeiteten gelegentlich nicht präzis, und der Zustand jeder Schellack nimmt heute zusätzlich Einfluss –, kann man für den wichtigsten Schritt im ganzen Prozess kaum je auf gesicherte Erkenntnisse zurück greifen. Der Restaurator muss die Parameter für jeden Transfer nach Gehör einstellen. Natürlich helfen ihm dabei Erfahrungswerte zeitnaher Aufnahmen desselben Labels im selben Studio mit demselben Orchester und im Lauf der Jahre zusammengestellte Listen Label-typischer Werte. Trotzdem gibt es immer wieder überraschende und unerklärliche Ausreisser, welche atypische Entzerrungs-Parameter erfordern.

Diese sogenannt technische Entzerrung kann man nicht mit herkömmlichen Equalizern von heute bewerkstelligen – aber auch nicht mit Vintage-Geräten der Wiedergabetechnik. Keine Handvoll Hersteller weltweit haben dafür heute ein Gerät im Angebot, welches nicht nur technisch, sondern auch klanglich makellos ist. Diese Gerätegattung ist ein extremer Nischenmarkt. Solche Geräte sind nicht ab Lager lieferbar. Diese analogen Technik-Preziosen werden auf Bestellung mit monatelanger Wartefrist gefertigt und individuell akribisch eingemessen ausgeliefert – als Einzelstück oder Kleinstserie, da der Markt weltweit jährlich kaum mehr als ein, höchstens zwei Dutzend dieser Geräte abnimmt. Zudem fordern manche Restauratoren Modifikationen nach ihren Vorgaben, womit so ein Gerät endgültig zum Unikat wird. Diesen winzigen Markt teilen sich mehrere Hersteller. Kleiner Hinweis: der mancherorts hochgelobte Vadlyd, ex Elberg, ist weder schaltungstechnisch noch klanglich gut genug für erstklassige Restaurationen. Das gilt auch für viele mit vergleichbarem Entwicklungs- und Produktionsaufwand hergestellte Geräte, die im Prosumer-Markt ihr Unwesen treiben. Gute Entzerrvorverstärker gibt es nicht zum Schnäppchenpreis.

Die nur stufenweise einstellbaren Entzerrkurven dieser Geräte müssen schaltungstechnisch und damit in Bezug auf ihre Wirkung komplementär genau gleich aufgebaut sein, wie jene Geräte, die damals im Aufnahmestudio für die Verzerrung eingesetzt wurden. Was für den in seiner Konstruktion einzigartigen Schneidekopf WE D-85’264 bis heute aus zwei Gründen nicht befriedigend gelöst ist: Zum einen müssten dazu die spezifischen Nebenwirkungen der mechanischen Dämpfung mit einem entsprechenden Set separater, genau dafür entwickelter Einstellungen kompensiert werden. Ich kenne bis heute kein Gerät auf dem Markt, dass solche Parameter anbietet. Zum anderen führt eine verzögerte, mechanische Rückkoppelung um 160Hz dazu, dass der Bassbereich aufgedickt wurde.Ich kenne bis heute kein Gerät auf dem Markt, dass solche Parameter anbietet.

Der Einsatz aktueller oder innovative Schaltungskonzepte führt in diesem alles entscheidenden Schritt nicht zu brauchbarem Klang, weil ein anderer technischer Aufbau der Regelglieder zu klanglich anderen Resultaten mit anderen Defiziten führen würde, die unnatürlich klingen, was bei Aufnahmen akustischer Musikinstrumente sofort hörbar ist. Hier weiter ins Detail zu gehen, würde den Rahmen eines Blogs endgültig sprengen. Aber wir können zum Abschluss DEN Satz von früher abwandeln: Wo alles natürlich ist, klingt falsch angepackt alles ganz schnell unnatürlich. Wieder mal im Gegensatz zu Pop-Konserven.

Nur so viel noch: Falls beim Transfer technisch korrekt entzerrt wird, klingen die damaligen Aufnahmen sogar ohne Restauration verblüffend gut. Wer so was noch nie auf makelloser Studiotechnik hören durfte, kann sich das kaum vorstellen, weil es unserem neomanischen Weltbild widerspricht. Die Differenz zwischen der heute kaum mehr bekannten innovativen Aufnahmetechnik der 30er- und 40er-Jahre und der heute weit verbreiteten Vorstellung einer rein mechanischen Wiedergabetechnik für damalige Consumer ist eine Sackgasse. Mit einem federmotorbetriebenen Grammophon mit mechanischer Verstärkung, also einer Tondose mit Stahlnadel und Diaphragma, die einen Schalltrichter beschwingen, lässt sich nicht wiedergeben, was in den Aufnahmen des TA der EdO steckt, obwohl auch das ein ziemlich ausgefuchstes System war. Richtig angewendet öffnet sich dank Technologie von damals mit Technologie von heute ein neue musikalische Welt. Damit machen sogar hochauflösende Daten als Distributionsformat Sinn, wie 24bit/96kHz. Das hat beinahe die Qualität einer Zeitmaschine – mit exorbitantem Suchtfaktor und lebenslanger Gänsehautgarantie.

Hochauflösende Audiodaten

Ich will nicht verschweigen, dass unter Kennern der Materie längst klar ist, dass die von manchen Anbietern seit Jahren propagierten hohen Abtastraten von 88,2 und 96, 176,4, 192kHz und darüber hinaus auch für anspruchsvolle Consumer ein datentechnischer Overkill sind, der auch neue Probleme schafft, anstatt ausschliesslich mehr Klangqualität zu ermöglichen weil der damit verbundene Rechenaufwand für DACs enorm ist. Allerdings wird darüber in Fachkreisen heftig gestritten. Und nicht alle Vertreter hoher Auflösungen sind Marketeers.

Von Consumern angestellte Vergleiche bringen nur mit selbst gemachten Aufnahmen brauchbare Resultate, weil ein Tester nur dann weiss, ob beiden Versionen mit Ausnahme des Runterrechnens der einen Version gleich behandelt wurden. Aber ohne Blindtest ist so ein Vergleich sinnlos. Bei kommerziell angebotenen, hochauflösenden Aufnahmen sind nicht immer red-book-konforme Versionen zwecks Vergleich vorhanden. Und wenn doch, führen Test trotzdem meist nicht zum Ziel. Weil einzig der vom Label beauftragte Mastering-Ingenieur wissen kann, was im Vorfeld der Neuveröffentlichung genau gemacht wurde. Wo eine 24/>44,1-Ausgabe besser klingt als die 16/44,1-Version, liegt die Ursache dafür oft nicht nur oder gar nicht in der höheren Auflösung begründet. Es versteht sich von selbst, dass die Label bereits beim Vorbereiten des hochauflösenden Materials unzählige Möglichkeiten haben, zusätzliche Veränderungen zu realisieren. Und das tun sie auch, in der Hoffnung damit die Verkäufe anzukurbeln.

Vor einigen Tagen habe ich zB 24/192-Versionen der frühen Aufnahmen der Beach Boys gehört. Die klangen fantastisch. So habe ich die Beach Boys niemals vorher gehört. Aber eben: Ich habe keine Ahnung, ob meine Begeisterung der hohen Auflösung der digitalen Daten geschuldet ist, oder den vielen anderen Massnahmen, die im Rahmen so einer Neuedition vom Label logischerweise immer realisiert werden. So betrachtet sind viele hochauflösenden Angebot Mogelpackungen. Falls sie toll klingen, ist das für trotzdem kein Grund sie nicht zu kaufen. Man sollte sich als Käufer solcher Mechanismen lediglich bewusst ist.

Im Rahmen der Initialphase bei TangoTunes im Jahr 2014 – dazu später mehr – hatte ich zum bisher ersten und letzten mal Gelegenheit, im Format 24/96 gemachte Restaurationen zu vergleichen, von denen beim mastern lediglich Versionen in mehrere Formate runter gerechnet wurden. Verglichen wurden das Ursprungsformat 24/96 mit 16/44,1 und einem komprimierten Format. Die gut hörbaren Unterschiede haben zur Entscheidung geführt, die Golden Ear Edition nur in den Formaten 24/96 FLAC und 16/44,1 AIFF zu veröffentlichen und auf ein komprimiertes Format zu verzichten. Die hochauflösende Version bietet klanglich einen Reichtum an Farben und Details, welche die red-book-Version nicht bieten kann – auch mit diesen alten, zwangsläufig suboptimalen Aufnahmen. Angesichts der künstlerischen Qualitäten der Toporchester der EdO würde weniger Qualität keinen Sinn machen.

Das klangliche Optimum wird wohl bereits zwischen 60 und 70kHz erreicht, sagen Entwickler, die davon tatsächlich was verstehen. Ich halte solche Ansichten für gut begründet. Für Schellackplatten gilt das glaube ich sowieso, aber vielleicht täusche ich mich da. Um solchen Dingen auf den Grund zu gehen, muss man in diesem Fachgebiet beruflich tätig sein. Dass TangoTunes trotzdem 96kHz anbietet, hat lediglich damit zu tun, dass viele Wandler auf dem Markt nur mit den etablierten, fixen Abtastraten zurecht kommen. Mit dem ehemaligen Studiostandard von 48kHz sind optimale klangliche Resultate aber noch nicht realisierbar und mit den 44,1kHz der Red-Book-CD für Consumer sowieso nicht.

Inwieweit Wortbreiten über 24bit für die Speicherung Sinn machen, darüber streiten sich die Fachleute. Aber weniger macht keinen Sinn, vor allem dann, wenn noch Spielraum für Bearbeitung vorhanden sein soll, wie manche DJs das wünschen. Dafür ist 24/48 ein Minimum. Dazu gehört auch so etwas Banales wie eine Pegeländerung, die nicht in ein Tag eingetragen wird. Aber auch in diesem Aspekt ist die Situation komplexer, als man sich wünscht. Denn zu Beginn der digitalen Ära wurde im Aufnahmestudio mit 16/44,1 und ganz am Anfang mit 14/44,1 gearbeitet, weil die erste Generation Studiogeräte mehr Rechenleistung nicht bieten konnte und klanglich trotzdem überraschend gute Resultate bot. Es ist für Consumer unmöglich zu klären, wann bei welchem Label der Wechsel von 14 oder 16/44,1 auf 24/48 stattgefunden hat. Decca zB hat für Aufnahmen rund zehn Jahre lang das nicht mit dem CD-Standard kompatible digitale System der Firma Soundstream verwendet.

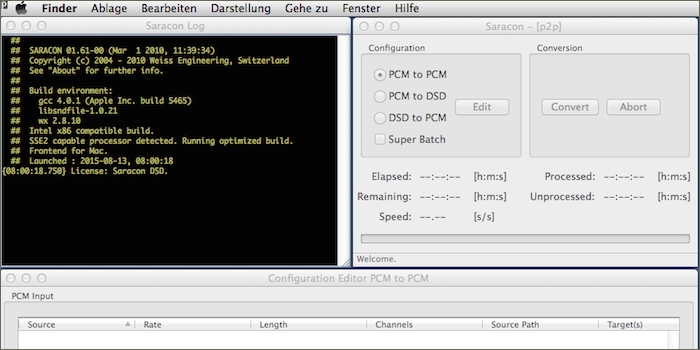

DJs, die sich einbilden, sie wären in der Lage, auf ihrem Laptop hochauflösende Audiodaten in irgend einer DAW selbst runter zu rechnen, durchschauen die Materie nicht. Seit Jahren sind sich Tonmeister im Klaren darüber, dass nur Hard- oder Software dieser Aufgabe gewachsen ist, die ausschliesslich für diese Berechnungen entwickelt wurde, wie zB die Software Saracon von Weiss. Eierlegende Wollmilchsäue wie zB ProTools bieten diese Funktionalität auch. Klanglich sind deren Resultate aber nicht befriedigend.

Nochmals zur Entzerrung

Auch wenn sogar die meisten Tontechniker heute davon nichts (mehr) wissen: Gute Restaurationen von Schellacks bedingen aus mathematischen Gründen, die sich hörbar auswirken, dass technische Entzerrung und ästhetisches Equalizing als eigenständige Schritte voneinander getrennt werden, vorgenommen mit unterschiedlichen Gerätschaften. Wo das geschulte Gehör und die lange Erfahrung fehlen, um diese Trennung einwandfrei vorzunehmen und sich im ersten Schritt auf eine mathematisch korrekte technische Entzerrung zu beschränken, wird jede Restauration am Ende bestenfalls medioker klingen, weil das Resultat einer korrekten technischen Entzerrung nicht zwangsläufig gut klingen muss. Sie muss lediglich technisch korrekt sein. Und das kann sich unbefriedigend anhören. Das ist alles andere als einfach zu realisieren, weil dieser Schritt trotzdem nach Gehör justiert werden muss. Das kann man nicht messen, geschweige denn grafisch darstellen. Nicht mit Schellacks mit Aufnahmen von damals und nicht Schellack-Messplatten von damals. Weil beide neu und damit in makelloser Qualität nicht mehr erhältlich sind und dem der Materialmix der Schellack im Weg steht. Kommt hinzu, dass die einzige neu lieferbare Messplatte für 78rpm in Vinyl gepresst ist, was praktische Einschränkungen mit sich bringt. Manche Tests lassen sich damit gar nicht durchführen. Wenn diese beiden technologisch wie funktional vollkommen unterschiedlichen Schritte vermischt werden, klingt das nicht nur unbefriedigend. Dann werden auch fall back Szenarien verunmöglicht, die es erlauben, kleinere Fehler im Restaurationsprozess mit moderatem Aufwand zu beheben, indem man lediglich einen Schritt im Prozess zurück springt, anstatt mit dem Transfer nochmals ganz von vorne zu beginnen.

Während der sechs Monate, die ich für TangoTunes tätig war – dazu weiter unten mehr – war dies die grösste Herausforderung, mit der ich persönlich konfrontiert war: Neben der Projektleitung gehörte es zu meinen Aufgaben, die technische Entzerrung unseres Restaurations-Cracks zu genehmigen, bevor er den nächsten Schritt im Prozess in Angriff nahm. Denn auch der benötigt einen Partner für seine Tätigkeit. Restaurationen erstellen ist eine einsame Arbeit. Trotzdem darf man dabei nie in Routine verfallen. Auch hier gilt, wovon in den letzen Jahren in unserer Gesellschaft öfter die Rede ist: das Vieraugenprinzip – wobei wir im Team von TangoTunes in der Initialphase natürlich dem Vierohrenprinzip gehuldigt haben.

Eine Fehlentscheidung meinerseits hätte pro Restauration zu Mehraufwand geführt, weil man dann gegen Ende einer betroffenen Restauration nochmals ganz von vorne mit dem Transfer hätte beginnen müssen. Und einige Male habe ich natürlich genau das verursacht. Anfangs fehlte mir die praktische Erfahrung für belastbare Entscheidungen. Ich wusste lediglich theoretisch, was zu tun ist. Daher musste ich oft Rücksprache mit unserem Restaurations-Crack halten und habe mich dennoch gelegentlich verhauen. Wir haben in diesen ersten Wochen viel und oft genug kontrovers miteinander debattiert und ich habe wieder mal unglaublich viel lernen dürfen. Aber ich konnte ihm in dieser Zeit auch einiges näher bringen, was für TA der EdO in Hinblick auf Tänzer wichtig ist. Beste Tonmeister finden zu den Aufnahmen von Pugliese immer Zugang. Diese Musik gefällt ihnen auch. Bei Biagi oder d’Arienzo ist dieser Zugang meist kaum vorhanden, was es schwierig macht, Tonmeistern manche Anforderungen so zu vermitteln, dass sie diese umsetzen, weil sie sie verstehen, anstatt lediglich Forderungen zu erfüllen, die ihnen widerstreben, weil sie sie nicht verstehen.

Heute weiss ich in etwa, was bei diesem elementaren Schritt der Restauration gefragt ist und kann einigermassen mitreden. Aber noch immer ist mein Frustfaktor bei dieser Teamarbeit hoch. Ich höre schnell, wenn etwas klanglich nicht stimmt. Aber noch kann ich zu oft nicht sofort benennen, wo im Musikgeschehen was die Probleme verursacht, geschweige denn, wie das zu kurieren ist. In Gesprächen hat mir unser Restaurations-Crack beinahe jedesmal innert Sekunden sagen können, wohin genau in der Musik ich hören soll, um den Übeltäter dingfest zu machen. Dann war auch mir jedesmal klar, was Sache ist. Und ich habe nicht verstanden, wieso ich das nicht von allein sofort herausgehört habe. Seine Grenzen dermassen deutlich aufgezeigt zu bekommen, ist so lehrreich wie ernüchternd.

Nach wie vor bin ich nicht in der Lage, jenen elementaren Multischritt, der vier Dinge vereint, in der geforderten Qualität selbst vorzunehmen. Dazu bedarf es einer ziemlich raren Spezies auf diesem Planeten: eines Restaurations-Cracks aus dem Genre Klassik, mit Erfahrung zuhauf. Wir hatten Leute im Team – Namen sind unwichtig – die überzeugt waren, diesen Multischritt zu beherrschen. Und jeder dieser Teamplayer verfügte über eine ganze Reihe beachtlicher Kompetenzen. Dass sie daran trotzdem scheitern, haben ihre Resultate schnell hören lassen. Diesen Multischritt richtig zu machen ist wie das Jonglieren eines Dutzends Bälle gleichzeitig – ohne Unterbruch über diesen Multischritt hinaus, über ein halbes Dutzend weiterer Prozessschritte und damit eine ganze Woche hinweg, die mit dem ersten Multischritt in komplexem Zusammenhang stehen. Hier gilt natürlich mehr denn je: Changing anything affects everything, weil neben der recht gut beherrschbaren momentanen Ereignisachse auf der Zeitachse umfassende Komplexität hinzukommt, die vielerlei irreversibel machen kann.

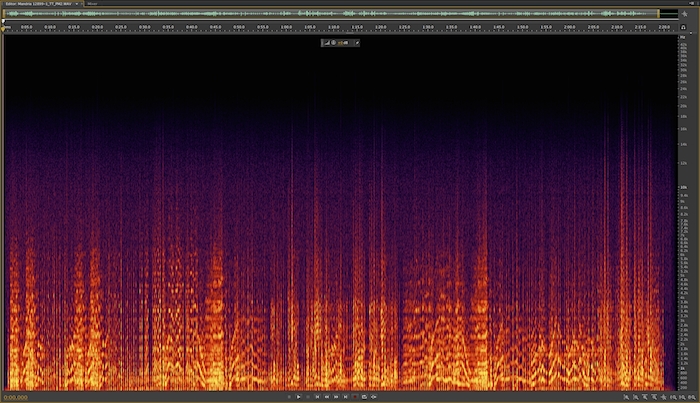

Visuelle Analysemethoden

Unser Restaurations-Crack hat immer die Augen verdreht, wenn einer der Amateure im Team – und das wir waren alle, ausser unserem Tonmeister Andrew – mit grafischen Darstellungen, wie zB Spektralanalysen einer Aufnahme, versucht hat, irgendwas zu erklären oder daraus abzuleiten. In der Audiowelt ist und bleibt das Gehör das ultimative und vor allem ein intuitives und sehr viel intelligenteres und pragmatischeres Instrument als jegliche Technik. Viele Details, welche ein geschultes Ohr problemlos heraushört, lassen sich kaum oder gar nicht messtechnisch erfassen, oder nur mit grossem Aufwand, teuren Messapparaturen.

Die Audioindustrie bildet seit Jahrzehnten akustische Signale visuell ab. Bei Lautheit funktioniert das längst bestens. Was da in den letzten Jahren an Innovation entstanden ist, ist toll. Und trotzdem sind sogar in diesem technologisch verhältnismässig einfachen Feld immer noch Defizite vorhanden. Für viele komplexere Anwendungen wird das noch lange Krücke bleiben, und noch nicht mal eine gute – ganz egal wie beeindruckend so was auf dem Bildschirm aussieht. Bei der DAW Audition geht Adobe inzwischen so weit, dass man wie in Fotoshop Fotos in Audition Audio mittels Maus oder drucksensitivem Stift bearbeiten kann. Gear heads sind davon natürlich begeistert und verlieren den Bezug zur Realität. Zum einen bedingen solche Tools sowohl zur Analyse als auch zur Bearbeitung viel Erfahrung des Operateurs. Zum anderen ist es nicht einfach, die Parameter so einer Darstellung für Restaurationen optimal einzustellen. Ausserdem zeigen solche Tools verschiedener Entwickler für dieselbe Aufnahme völlig unterschiedliche Bilder. Es gibt also keinerlei Standards.

Es gibt es bei solcher Software einen offensichtlichen Killer-Faktor: Beim Bearbeiten sehen wir zwar, was wir tun. Aber wir haben keine Ahnung, wie sich anhört, was wir tun. Weil wir auf diesem visuellen Interface mit unmittelbarer Rückmeldung nicht hörbare Töne, sondern sichtbare Farben verändern. Es ist auch mit viel Erfahrung unmöglich, diese Übersetzung vom Sehen zum Hören beim Arbeiten simultan vorzunehmen, ohne sich dauernd anzuhören, was man gemacht hat – also quasi nach beinahe jedem Pinselstrich. Denn es ist nicht einfach so, dass zB rote Farbe schlecht und grüne Farbe gut signalisiert. Auch Erfahrung hilft da nur bedingt weiter. Und damit ist der von der Industrie versprochene enorme Zeitgewinn Makulatur. Wir sehen zudem nicht, wann wir beginnen, Artefakte zu kreieren oder zu verstärken, oder Dropouts zu produzieren, ohne uns nach beinahe jeder Mausbewegung anzuhören, was wir gemacht haben. Es gibt stichhaltige Gründe dafür, dass der Restaurations-Crack im Team von TangoTunes von dem knappen Dutzend Kategorien Restaurations-Algorithmen im Markt lediglich eine einzige partiell spärlich einsetzt. Auditions Spektralanalysenbearbeitung gehört nicht zu seinen Werkzeugen. Ob sich das in den nächsten Jahren ändern kann, müssen wir abwarten. Ich wäre nicht erstaunt, wenn erst in zehn Jahren klar ist, wo so ein Werkzeug Sinn macht und wo nicht.

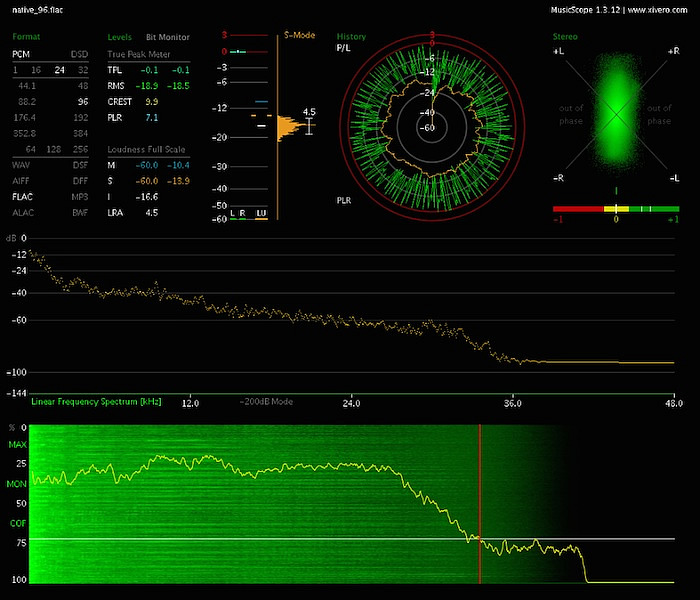

Blogger Jens-Ingo wiederum versucht in seiner Besprechung der Golden Ear Edition von TangoTunes, auf die der Autor verlinkt, aus anderen visuellen Analysen (stärkste Aussteuerung aller Impulse einer Aufnahme über das ganze Frequenzspektrum hinweg und die daraus entstehende Frequenzkurve) Rückschlüsse zu ziehen. Das Bewerten der dabei entstehenden Kurven funktioniert für Restaurationen gar nicht. Für manche wissenschaftliche Arbeiten können solche Werkzeuge dagegen von Nutzen sein.

In der Restaurationsarbeit – einer in ihrer praktischen Komplexität stark handwerks- und erfahrungsgeprägten Tätigkeit, in der die Parameter für ein knappes Dutzend Schritte hintereinander justiert und realisiert werden müssen, aber am Ende trotzdem zu einem funktionierenden Kompromiss mit starken gegenseitigen Abhängigkeiten, auch chronologisch rückwärts gewandten, verwoben sind – hat so ein auf den Moment beschränktes und wenigdimensionales, theoriefokussiertes Tool kaum praktischen Wert, welches mit einem anderen Sinnesorgan als Kontrollinstanz arbeitet. Das hängt auch damit zusammen, dass der unterschiedliche Störgeräuschpegel jeder einzelnen Schellack logischerweise zu jedes Mal etwas anderen Frequenzspektren führt.

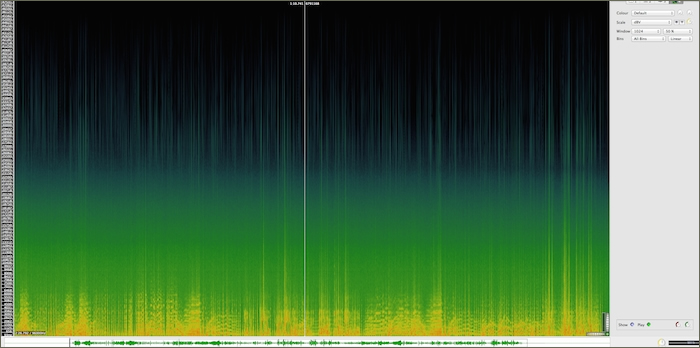

Als nützlich für manche DJs kann sich dagegen die Analyse-Software MusicScope erweisen. Sie ist einfach zu bedienen, listet viele Eckwerte auf einen Blick auf und erlaubt es, neben vielen anderen Dingen, schnell zu erkennen, ob eine Musikdatei übersteuert wurde, auch intersample peaks sind so schnell identifiziert. Nicht erkennbar damit ist logischerweise, ob eine Musikdatei in einem früheren Stadium von Entwicklung oder Distribution übersteuert und gespeichert, hinterher wieder pegelreduziert und neu gespeichert wurde, wodurch die provozierten Verzerrungen natürlich nie mehr entfernt werden können – was nicht nur bei Musik aus dubiosen Quellen vorkommt. Solchen Defiziten kommen DJs nur hörend auf die Spur. MusicScope ist auch als Plugin lieferbar und damit zwecks optimalem workflow in manche Software Player integrierbar.

Des Blog-Autors Sackgasse

Inzwischen sollte klar geworden sein, warum die ganze Argumentation des Autors ins Leere läuft. Sein Versprechen, mit einfachsten Mitteln den Frequenzgang der alten Aufnahmen zurechtzubiegen, kann auf Grund physikalischer Gesetze und technischer Gegebenheiten im Zusammenhang mit dem für Schellacks entwickelten, ausgezeichneten, puristischen Direktschnittverfahren auf Wachsmatrizen in der Praxis gar nicht funktionieren. Das ist banale Physik.